نمودار نحوه عملکرد یک موتور جستجو نحوه کار موتورهای جستجو - قطعات، الگوریتم جستجوی معکوس، نمایه سازی صفحات و ویژگی های Yandex

ما کتاب جدیدی منتشر کردهایم، بازاریابی محتوای رسانههای اجتماعی: چگونه به درون سر دنبالکنندگان خود وارد شوید و آنها را عاشق برند خود کنید.

نحوه کار یک موتور جستجو - اصول اولیه

هر کاربر اینترنتی کم و بیش با تجربه می تواند اطلاعات لازم را با استفاده از موتور جستجو پیدا کند. با این حال، تنها تعداد کمی از مردم می دانند که موتورهای جستجو چگونه کار می کنند. به راستی، گوگل یا یاندکس چگونه میتوانند درخواست کاربر را در عرض چند ثانیه تجزیه و تحلیل کنند و از بین میلیونها پروژه وب موجود در اینترنت، مناسبترین سایتها را انتخاب کنند؟

برای درک نحوه عملکرد موتورهای جستجو، باید با مفاهیمی مانند نمایه سازی و تولید نتایج آشنا شوید. در واقع، نقش یک موتور جستجو به تجزیه و تحلیل سایت های موجود در شبکه و خروجی اطلاعاتی که به بهترین وجه با نیازهای کاربر اینترنت مطابقت دارد، خلاصه می شود.

ویدیوهای بیشتر در کانال ما - بازاریابی اینترنتی را با SEMANTICA یاد بگیرید

چگونه یک موتور جستجو کار می کند - نمایه سازی سایت

ربات های جستجویی وجود دارند که دائماً در اینترنت "راه می روند" و از تمام سایت های شناخته شده برای آنها با فرکانس خاصی بازدید می کنند. ربات پس از کشف مطالب جدید، آن را به صورت متن ساده به پایگاه داده فهرست خود اضافه می کند. هر موتور جستجو دارای نوعی "نمایه کارت" است که در آن کپی هایی از صفحات وب نمایه شده ذخیره می شود.

اگر ربات از صفحه ای که قبلاً نمایه شده است بازدید کند، نسخه موجود را با وضعیت فعلی سند مقایسه می کند. اگر مغایرت های قابل توجهی وجود داشته باشد (اگر مطالب به روز شده باشد)، تغییراتی در پایگاه داده ایندکس ایجاد می شود.

نصیحت! هر چه یک سایت بیشتر به روز شود، ربات های جستجوگر بیشتر از آن بازدید می کنند. این امر تأثیر مثبتی در نمایه سازی خواهد داشت.

ایجاد نتایج مرتبط

اصول دقیق نحوه کار موتورهای جستجو کاملاً محرمانه است. علاوه بر این، الگوریتم ها به طور مداوم در حال بهبود و تغییر هستند. با این حال، کاملاً بدیهی است که موضوع سند بر اساس تحلیل معنایی آن تعیین می شود. موتورهای جستجو ممکن است به جنبه های زیر توجه کنند:

- فراوانی استفاده از پرس و جوهای کلیدی؛

- مطابقت موضوعی مطالب با موضوع اصلی سایت؛

- وجود مترادف برای عبارات کلیدی؛

- وجود کلید در عناوین، متا تگ ها و غیره

البته موتورهای جستجو نه تنها کیفیت متن، بلکه بسیاری از پارامترهای دیگر را نیز در نظر می گیرند. آنچه مهم است اعتماد به سایت، قدمت دامنه و وضعیت پایگاه لینک است. اخیراً عوامل رفتاری اهمیت زیادی پیدا کرده اند (فعالیت کاربر - تعداد صفحات مشاهده شده، نظرات و غیره).

موتورهای جستجو چگونه کار می کنند - پاسخ به پرسش

بر اساس پرس و جوی جستجوی وارد شده، سیستم مواد نمایه شده را تجزیه و تحلیل می کند. سپس ربات پیوندهایی را به سایت هایی ایجاد می کند که به بهترین نحو درخواست کاربر را برآورده می کنند. اخیراً تغییراتی در نحوه کار موتور جستجو ایجاد شده است. اکنون روباتها نتایج جستجو را با در نظر گرفتن ترجیحات کاربر تولید میکنند.

بیایید با یک مثال خاص توضیح دهیم: دو کاربر وجود دارد که یکی از آنها به دستورهای آشپزی علاقه دارد و دیگری اغلب در خانه فست فود سفارش می دهد. این کاربران ممکن است همان عبارت «پیتزای خوشمزه» را وارد کنند، اما موتور جستجو پیوندهایی به سایتهای مختلف در اختیار آنها قرار میدهد. اولی لیستی از دستور العمل های تهیه پیتزا را دریافت می کند و دومی آدرس رستوران های متخصص در تحویل این غذا را دریافت می کند.

با سلام خدمت خوانندگان محترم سایت وبلاگ. هنگام انجام یا به عبارتی بهینه سازی برای موتورهای جستجو، چه در سطح حرفه ای (ترویج پروژه های تجاری برای پول) و چه در سطح آماتور () قطعاً با این واقعیت مواجه خواهید شد که باید اصول کار را به طور کلی بدانید. به منظور بهینه سازی موفقیت آمیز سایت خود یا شخص دیگری برای آنها.

همانطور که می گویند دشمن باید با دید شناخته شود ، اگرچه البته آنها (برای RuNet این Yandex است و) برای ما اصلاً دشمن نیستند بلکه شریک هستند ، زیرا سهم آنها از ترافیک در بیشتر موارد غالب است. و اصلی البته استثناهایی وجود دارد، اما آنها فقط این قاعده را تأیید می کنند.

اسنیپت چیست و موتورهای جستجو چگونه کار می کنند؟

اما در اینجا، ابتدا باید بفهمید که یک اسنیپت چیست، برای چیست و چرا محتوای آن برای بهینه ساز بسیار مهم است؟ در نتایج جستجو بلافاصله در زیر پیوند به سند یافت شده قرار دارد (متن آن از آنچه قبلاً نوشتم گرفته شده است):

قطعات متن از این سند معمولا به عنوان یک قطعه استفاده می شود. گزینه ایده آل به گونه ای طراحی شده است که کاربر فرصتی برای ایجاد نظر در مورد محتوای صفحه بدون مراجعه به آن داشته باشد (اما این در صورتی است که موفقیت آمیز باشد و همیشه اینطور نیست).

قطعه به طور خودکار تولید می شود و این شما هستید که تصمیم می گیرید از کدام قطعات متنی در آن استفاده شود، و آنچه مهم است، همان صفحه وب برای درخواست های مختلف قطعه های مختلفی دارد.

اما این احتمال وجود دارد که گاهی اوقات بتوان از محتوای تگ Description (به خصوص در گوگل) به عنوان یک قطعه استفاده کرد. البته این به نتایج جستجویی که در آن ظاهر می شود نیز بستگی دارد.

اما محتویات تگ Description را می توان نمایش داد، به عنوان مثال، اگر کلمات کلیدی پرس و جو با کلماتی که در توضیحات استفاده کرده اید منطبق باشند یا اگر خود الگوریتم هنوز تکه های متنی را در سایت شما برای همه جستارهایی که صفحه شما در آنها نشان داده می شود پیدا نکرده باشد. نتایج Yandex یا Google

بنابراین، تنبل نباشید و محتویات برچسب توضیحات را برای هر مقاله پر کنید. این را می توان در وردپرس انجام داد اگر از آنچه توضیح داده شد استفاده کنید (و من قویاً توصیه می کنم از آن استفاده کنید).

اگر از طرفداران جوملا هستید، می توانید از این مطالب استفاده کنید -.

اما قطعه را نمی توان از شاخص معکوس به دست آورد، زیرا اطلاعات را فقط در مورد کلمات استفاده شده در صفحه و موقعیت آنها در متن ذخیره می کند. دقیقاً برای ایجاد تکههایی از یک سند در نتایج جستجوی مختلف (برای سؤالات مختلف) است که Yandex و Google محبوب ما علاوه بر نمایه معکوس (که مستقیماً برای انجام جستجو لازم است - در مورد آن در زیر بخوانید) نیز ذخیره میکنند. شاخص مستقیم، یعنی یک کپی از صفحه وب

با ذخیره یک کپی از سند در پایگاه داده خود، پس از آن برای آنها کاملا راحت است که قطعه های لازم را از آنها بدون مراجعه به اصل برش دهند.

که به نظر می رسد که موتورهای جستجو هر دو شاخص رو به جلو و معکوس صفحه وب را در پایگاه داده خود ذخیره می کنند. ضمناً میتوانید با بهینهسازی متن صفحه وب بهطور غیرمستقیم بر شکلگیری قطعهها تأثیر بگذارید، به گونهای که الگوریتم دقیقاً قطعه متنی را که در ذهن دارید انتخاب کند. اما در مقاله دیگری در این بخش در مورد این موضوع صحبت خواهیم کرد.

به طور کلی موتورهای جستجو چگونه کار می کنند

ماهیت بهینهسازی این است که به الگوریتمهای موتورهای جستجو کمک کنید تا صفحات سایتهایی را که تبلیغ میکنید به بالاترین موقعیت ممکن در نتایج جستجو برای پرس و جوهای خاص ارتقا دهند.

کلمه کمک را در جمله قبل در گیومه قرار دادم، زیرا ... با اقدامات بهینهسازی خود، ما واقعاً کمکی نمیکنیم، و اغلب به طور کامل مانع از ایجاد نتایج کاملاً مرتبط با درخواست (در مورد موارد مرموز) توسط الگوریتم میشویم.

اما این نان و کره بهینه سازان است و تا زمانی که الگوریتم های جستجو کامل شوند، فرصت هایی از طریق بهینه سازی داخلی و خارجی برای بهبود موقعیت خود در نتایج Yandex و Google وجود خواهد داشت.

اما قبل از اینکه به مطالعه روش های بهینه سازی بپردازید، باید حداقل به طور سطحی اصول نحوه کار موتورهای جستجو را درک کنید تا بتوانید تمام اقدامات بعدی را آگاهانه انجام دهید و درک کنید که چرا این کار ضروری است و چگونه کسانی که ما سعی در فریب آنها داریم. به آن واکنش نشان دهند.

واضح است که ما نمیتوانیم کل منطق کار آنها را از ابتدا تا انتها درک کنیم، زیرا اطلاعات زیادی در معرض افشا نیست، اما برای ما در ابتدا درک اصول اساسی کافی خواهد بود. پس بیایید شروع کنیم.

به هر حال موتورهای جستجو چگونه کار می کنند؟ به اندازه کافی عجیب، اما منطق کار آنها در اصل یکسان است و به شرح زیر است: اطلاعات در مورد تمام صفحات وب در شبکه که می توانند به آنها دسترسی پیدا کنند جمع آوری می شود و پس از آن این داده ها با حیله گری پردازش می شوند تا برای آنها راحت باشد. آنها جستجو می کنند. این همه چیز است، در واقع، این مقاله را می توان کامل در نظر گرفت، اما اجازه دهید هنوز کمی جزئیات اضافه کنیم.

ابتدا، اجازه دهید توضیح دهیم که سند همان چیزی است که ما معمولاً صفحه سایت می نامیم. علاوه بر این، باید آدرس منحصر به فرد خود را داشته باشد () و آنچه قابل توجه است، پیوندهای هش منجر به ظاهر شدن یک سند جدید (درباره) نمی شود.

ثانیاً، ارزش دارد روی الگوریتمها (روشها) جستجوی اطلاعات در پایگاه داده اسناد جمعآوریشده تمرکز کنیم.

الگوریتم های شاخص مستقیم و معکوس

بدیهی است که روش تکرار ساده از طریق تمام صفحات ذخیره شده در پایگاه داده بهینه نخواهد بود. به این روش الگوریتم می گویند جستجوی مستقیمو در حالی که این روش به شما امکان می دهد مطمئناً اطلاعات لازم را بدون از دست دادن چیز مهم پیدا کنید، برای کار با حجم زیادی از داده ها کاملاً نامناسب است، زیرا جستجو زمان زیادی را می گیرد.

بنابراین، برای کار موثر با حجم زیاد داده، یک الگوریتم شاخص معکوس (معکوس) توسعه داده شد. و نکته قابل توجه این است که همه موتورهای جستجوی بزرگ دنیا از آن استفاده می کنند. بنابراین، ما در مورد آن با جزئیات بیشتر صحبت خواهیم کرد و اصول عملکرد آن را در نظر خواهیم گرفت.

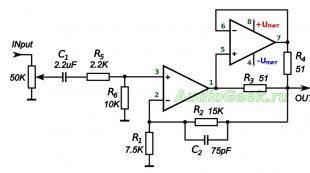

هنگام استفاده از الگوریتم شاخص های معکوساسناد به فایل های متنی حاوی لیستی از تمام کلمات موجود در آنها تبدیل می شوند.

کلمات موجود در چنین فهرستهایی (فایلهای فهرست) به ترتیب حروف الفبا مرتب شدهاند و در کنار هر یک از آنها به صورت مختصات مکانهایی در صفحه وب که این کلمه در آن قرار میگیرد نشان داده شدهاند. علاوه بر موقعیت در سند، برای هر کلمه پارامترهای دیگری نیز وجود دارد که معنای آن را تعیین می کند.

اگر به خاطر داشته باشید، در بسیاری از کتاب ها (عمدتاً فنی یا علمی) در صفحات آخر فهرستی از کلمات به کار رفته در این کتاب وجود دارد که شماره صفحاتی که در آن ظاهر می شوند را نشان می دهد. البته این لیست شامل تمام کلمات استفاده شده در کتاب نمی شود، اما با این وجود می تواند به عنوان نمونه ای از ساخت یک فایل فهرست با استفاده از نمایه های معکوس باشد.

لطفا توجه داشته باشید که موتورهای جستجو به دنبال اطلاعات هستند نه در اینترنت، و در نمایه های معکوس صفحات وب که پردازش می کنند. اگرچه آنها نمایه های مستقیم (متن اصلی) را نیز ذخیره می کنند، زیرا بعداً برای جمعآوری قطعهها مورد نیاز خواهد بود، اما قبلاً در ابتدای این انتشار در مورد آن صحبت کردیم.

الگوریتم شاخص معکوس توسط همه سیستم ها استفاده می شود، زیرا این به شما امکان می دهد روند را تسریع کنید، اما در عین حال به دلیل اعوجاج هایی که با تبدیل سند به یک فایل فهرست ایجاد می شود، اطلاعات اجتناب ناپذیری از دست خواهد رفت. برای سهولت در ذخیره سازی، فایل های فهرست معکوس معمولاً به روشی هوشمندانه فشرده می شوند.

مدل ریاضی مورد استفاده برای رتبه بندی

به منظور جستجو با استفاده از نمایههای معکوس، از یک مدل ریاضی برای سادهسازی فرآیند شناسایی صفحات وب لازم (بر اساس پرسوجوی وارد شده توسط کاربر) و فرآیند تعیین ارتباط همه اسناد یافت شده با این پرسوجو استفاده میشود. هر چه بیشتر با یک درخواست داده شده مطابقت داشته باشد (هرچه مرتبط تر باشد)، باید در نتایج جستجو بالاتر ظاهر شود.

این بدان معنی است که وظیفه اصلی انجام شده توسط مدل ریاضی جستجوی صفحات در پایگاه داده نمایه های معکوس مربوط به یک پرس و جو و مرتب سازی بعدی آنها به ترتیب نزولی مربوط به این پرس و جو است.

استفاده از یک مدل منطقی ساده، زمانی که سندی پیدا میشود، اگر عبارت جستجو شده در آن یافت شود، به دلیل تعداد زیادی از چنین صفحات وب که برای بررسی به کاربر ارائه میشوند، مناسب ما نخواهد بود.

موتور جستجو نه تنها باید فهرستی از تمام صفحات وب را که کلمات حاصل از پرس و جو در آنها ظاهر می شود ارائه دهد. او باید این لیست را به گونه ای ارائه کند که اسنادی که بیشترین ارتباط را با درخواست کاربر دارند در همان ابتدا باشند (مرتب سازی بر اساس ارتباط). این کار بی اهمیت نیست و به طور پیش فرض نمی تواند به طور کامل انجام شود.

به هر حال، بهینه سازها از ناقص بودن هر مدل ریاضی استفاده می کنند و به نوعی بر رتبه بندی اسناد در نتایج جستجو تأثیر می گذارند (البته به نفع سایتی که آنها را تبلیغ می کنند). مدل ریاضی مورد استفاده همه موتورهای جستجو متعلق به کلاس برداری است. از مفهومی به عنوان وزن یک سند در رابطه با پرس و جوی مشخص شده توسط کاربر استفاده می کند.

در مدل بردار پایه، وزن یک سند برای یک پرس و جو بر اساس دو پارامتر اصلی محاسبه می شود: فراوانی که یک کلمه معین در آن ظاهر می شود (TF - فرکانس ترم) و اینکه چقدر به ندرت این کلمه در تمام صفحات دیگر وجود دارد. مجموعه (IDF - فرکانس سند معکوس).

منظور از مجموعه، کل مجموعه صفحات شناخته شده توسط موتور جستجو است. با ضرب این دو پارامتر در یکدیگر، وزن سند را برای یک درخواست داده شده بدست می آوریم.

به طور طبیعی، موتورهای جستجوی مختلف، علاوه بر پارامترهای TF و IDF، از ضرایب مختلف زیادی برای محاسبه وزن استفاده می کنند، اما ماهیت یکسان است: وزن صفحه بیشتر خواهد شد، هرچه بیشتر کلمه از عبارت جستجو ظاهر شود. در آن (تا حد معینی که پس از آن سند به عنوان هرزنامه شناخته می شود) و کمتر این کلمه در سایر اسناد نمایه شده توسط این سیستم ظاهر می شود.

ارزیابی کیفیت فرمول توسط ارزیابان

بنابراین، معلوم می شود که تولید نتایج برای درخواست های خاص انجام می شود کاملا طبق فرمولبدون دخالت انسان اما هیچ فرمولی به خصوص در ابتدا کاملاً کار نخواهد کرد، بنابراین باید عملکرد مدل ریاضی را نظارت کنید.

برای این اهداف، از افراد آموزش دیده ویژه استفاده می شود - که نتایج (مخصوصاً موتور جستجویی که آنها را استخدام کرده است) را برای سؤالات مختلف مشاهده می کنند و کیفیت فرمول فعلی را ارزیابی می کنند.

تمام نظراتی که آنها می دهند توسط افرادی که مسئول تنظیم مدل ریاضی هستند در نظر گرفته می شود. تغییرات یا اضافاتی در فرمول آن ایجاد می شود که در نتیجه کیفیت کار موتور جستجو بهبود می یابد. به نظر می رسد که ارزیاب ها به عنوان نوعی بازخورد بین توسعه دهندگان الگوریتم و کاربران آن عمل می کنند که برای بهبود کیفیت ضروری است.

معیارهای اصلی برای ارزیابی کیفیت فرمول عبارتند از:

- دقت نتایج موتور جستجو درصدی از اسناد مرتبط (که با پرس و جو مطابقت دارند) است. هر چه تعداد صفحات وب (مثلاً درگاههای ورودی) که به موضوع درخواست مربوط نباشد، کمتر باشد، بهتر است.

- کامل بودن نتایج جستجو عبارت است از درصد صفحات وب مربوط به یک پرس و جو داده شده (مرتبط) به تعداد کل اسناد مرتبط موجود در کل مجموعه. آن ها معلوم می شود که در کل پایگاه داده اسنادی که برای جستجو شناخته شده اند، تعداد صفحات وب مربوط به یک پرس و جو داده شده بیشتر از آنچه در نتایج جستجو نشان داده شده است وجود خواهد داشت. در این صورت می توان در مورد ناقص بودن صدور صحبت کرد. این امکان وجود دارد که برخی از صفحات مربوطه زیر فیلتر افتاده باشند و به عنوان مثال با درگاه ها یا سرباره دیگری اشتباه گرفته شده باشند.

- ارتباط نتایج جستجو میزانی است که یک صفحه وب واقعی در یک وب سایت در اینترنت با آنچه در مورد آن در نتایج جستجو نوشته شده است مطابقت دارد. برای مثال، ممکن است سندی دیگر وجود نداشته باشد یا تغییرات زیادی داشته باشد، اما علیرغم عدم وجود فیزیکی آن در آدرس مشخص شده یا عدم انطباق فعلی آن با درخواست داده شده، در نتایج جستجو برای یک درخواست مشخص وجود دارد. ارتباط نتایج به فراوانی روبات های جستجوگر که اسناد مجموعه خود را اسکن می کنند بستگی دارد.

Yandex و Google چگونه مجموعه خود را جمع آوری می کنند

علیرغم سادگی ظاهری نمایه سازی صفحات وب، نکات ظریف زیادی وجود دارد که باید بدانید و متعاقباً هنگام بهینه سازی (SEO) وب سایت های شخصی یا سفارشی خود از آنها استفاده کنید. نمایه سازی شبکه (مجموعه مجموعه) توسط یک برنامه طراحی شده خاص به نام ربات جستجوگر (ربات) انجام می شود.

ربات یک لیست اولیه از آدرس هایی را دریافت می کند که باید از آنها بازدید کند، محتویات این صفحات را کپی کرده و این محتوا را برای پردازش بیشتر به الگوریتم می دهد (آنها را به نمایه های معکوس تبدیل می کند).

این ربات نه تنها میتواند فهرستی را که از قبل به آن داده شده است دنبال کند، بلکه میتواند پیوندهای این صفحات و اسناد ایندکس واقع در این پیوندها را دنبال کند. که ربات دقیقاً مانند یک کاربر معمولی که پیوندها را دنبال می کند رفتار می کند.

بنابراین، معلوم میشود که با کمک یک ربات، میتوان همه چیزهایی را که معمولاً با استفاده از مرورگر برای گشت و گذار در دسترس کاربر است، فهرست کرد (موتورهای جستجو اسناد خط دیدی را که توسط هر کاربر اینترنتی قابل مشاهده است فهرست میکنند).

تعدادی ویژگی مرتبط با نمایه سازی اسناد در اینترنت وجود دارد (اجازه دهید یادآوری کنم که قبلاً در مورد آن بحث کرده ایم).

اولین ویژگی را می توان در نظر گرفت که علاوه بر نمایه معکوس که از سند اصلی دانلود شده از اینترنت ایجاد می شود، موتور جستجو یک نسخه از آن را نیز ذخیره می کند، به عبارت دیگر موتورهای جستجو نمایه مستقیم را نیز ذخیره می کنند. چرا این لازم است؟ قبلاً کمی قبلاً ذکر کردم که این برای نوشتن قطعات مختلف بسته به پرس و جوی وارد شده لازم است.

Yandex چند صفحه از یک سایت را در نتایج جستجو و فهرست نشان می دهد؟

من می خواهم توجه شما را به چنین ویژگی کار Yandex جلب کنم، مانند وجود تنها یک سند از هر سایت در نتایج جستجو برای یک درخواست معین. تا همین اواخر، این اتفاق نمی افتاد که دو صفحه از یک منبع در موقعیت های مختلف در نتایج جستجو حضور داشته باشند.

این یکی از قوانین اساسی Yandex بود. حتی اگر صد صفحه مربوط به یک جستجوی داده شده در یک سایت وجود داشته باشد، تنها یک (مرتبط ترین) در نتایج ظاهر می شود.

Yandex علاقه مند است که کاربر اطلاعات مختلفی را دریافت کند و در چندین صفحه نتایج جستجو با صفحات همان سایت پیمایش نکند که این کاربر به دلایلی جالب نبود.

با این حال، من عجله دارم که خودم را اصلاح کنم، زیرا وقتی نوشتن این مقاله را به پایان رساندم، این خبر را فهمیدم که معلوم شد Yandex شروع به اجازه نمایش سند دوم از همان منبع در نتایج جستجو کرده است، به عنوان یک استثنا، اگر این صفحه معلوم می شود که "بسیار خوب و مرتبط" است (به عبارت دیگر، بسیار مرتبط با درخواست است).

نکته قابل توجه این است که این نتایج اضافی از همان سایت نیز شماره گذاری شده است، بنابراین، به همین دلیل، برخی از منابع که موقعیت های پایین تر را اشغال می کنند، از بالا خارج می شوند. در اینجا نمونه ای از خروجی جدید Yandex آمده است:

موتورهای جستجو تلاش میکنند تا همه وبسایتها را بهطور یکسان فهرستبندی کنند، اما اغلب این کار به دلیل تعداد صفحات کاملاً متفاوت روی آنها آسان نیست (برخی دارای ده و برخی دیگر ده میلیون صفحه هستند). در این صورت چه باید کرد؟

Yandex با محدود کردن تعداد اسنادی که می تواند از یک سایت در فهرست قرار دهد، از این وضعیت خارج می شود.

برای پروژه هایی با نام دامنه سطح دوم، به عنوان مثال، یک وب سایت، حداکثر تعداد صفحاتی که می تواند توسط یک آینه Runet ایندکس شود در بازه صد تا صد و پنجاه هزار است (تعداد خاص بستگی به رابطه دارد. به پروژه داده شده).

برای منابع با نام دامنه سطح سوم - از ده تا سی هزار صفحه (اسناد).

اگر وب سایتی با دامنه سطح دوم () دارید و برای مثال باید یک میلیون صفحه وب را ایندکس کنید، تنها راه برون رفت از این وضعیت ایجاد بسیاری از زیر دامنه ها () است.

زیر دامنه های یک دامنه سطح دوم ممکن است به این شکل باشند: JOOMLA.site. تعداد زیر دامنههای سطح دوم که Yandex میتواند ایندکس کند چیزی بیش از 200 (گاهی تا هزار) است، بنابراین به این روش ساده میتوانید چندین میلیون صفحه وب را در فهرست آینه RuNet قرار دهید.

نحوه برخورد Yandex با سایت ها در مناطق غیر روسی

با توجه به این واقعیت که تا همین اواخر Yandex فقط در بخش روسی زبان اینترنت جستجو می کرد، پروژه های عمدتاً روسی زبان را نمایه می کرد.

بنابراین، اگر در حال ایجاد وب سایتی هستید که در مناطق دامنه نیست، که به طور پیش فرض به عنوان روسی زبان (RU، SU و UA) طبقه بندی می شوند، پس نباید انتظار ایندکس سریع داشته باشید، زیرا او به احتمال زیاد آن را زودتر از یک ماه بعد پیدا نمی کند. اما نمایه سازی بعدی با همان فرکانس در مناطق دامنه روسی زبان انجام می شود.

آن ها ناحیه دامنه فقط بر زمانی که قبل از شروع نمایه سازی می گذرد تأثیر می گذارد، اما متعاقباً بر فرکانس آن تأثیر نمی گذارد. به هر حال، این فرکانس به چه چیزی بستگی دارد؟

منطق نحوه کار موتورهای جستجو برای فهرست مجدد صفحات تقریباً به موارد زیر می رسد:

- ربات پس از یافتن و فهرست بندی یک صفحه جدید، روز بعد از آن بازدید می کند

- با مقایسه مطالب با دیروز و عدم یافتن تفاوت، ربات فقط سه روز دیگر به آن می رسد.

- اگر این بار چیزی روی آن تغییر نکرد، یک هفته دیگر می آید و غیره.

که با گذشت زمان، دفعات بازدید ربات از این صفحه برابر یا قابل مقایسه با دفعات به روز رسانی آن خواهد بود. علاوه بر این، زمان ورود مجدد ربات را می توان برای سایت های مختلف هم بر حسب دقیقه و هم در سال اندازه گیری کرد.

اینها موتورهای جستجوی هوشمندی هستند که یک برنامه بازدید فردی برای صفحات مختلف منابع مختلف ایجاد می کنند. درست است، ما میتوانیم موتورهای جستجو را مجبور کنیم به درخواست ما یک صفحه را مجدداً فهرست کنند، حتی اگر چیزی در آن تغییر نکرده باشد، اما بیشتر در مورد آن در مقاله دیگری.

ما به بررسی اصول جستجو در مقاله بعدی ادامه خواهیم داد، جایی که به مشکلاتی که موتورهای جستجو با آن مواجه هستند و تفاوت های ظریف را در نظر خواهیم گرفت. خوب، و خیلی بیشتر، البته، این به یک روش کمک می کند.

موفق باشید برای شما! به زودی شما را در صفحات سایت وبلاگ می بینیم

ممکن است علاقه مند باشید

Rel Nofollow و Noindex - نحوه مسدود کردن پیوندهای خارجی در یک وب سایت از نمایه سازی توسط Yandex و Google

Rel Nofollow و Noindex - نحوه مسدود کردن پیوندهای خارجی در یک وب سایت از نمایه سازی توسط Yandex و Google  با در نظر گرفتن مورفولوژی زبان و سایر مشکلات حل شده توسط موتورهای جستجو و همچنین تفاوت بین پرس و جوهای فرکانس بالا، متوسط و فرکانس پایین

با در نظر گرفتن مورفولوژی زبان و سایر مشکلات حل شده توسط موتورهای جستجو و همچنین تفاوت بین پرس و جوهای فرکانس بالا، متوسط و فرکانس پایین  اعتماد به سایت - چیست، چگونه آن را در XTools اندازه گیری کنیم، چه چیزی بر آن تأثیر می گذارد و چگونه اعتبار سایت خود را افزایش دهیم

اعتماد به سایت - چیست، چگونه آن را در XTools اندازه گیری کنیم، چه چیزی بر آن تأثیر می گذارد و چگونه اعتبار سایت خود را افزایش دهیم  اصطلاحات، کلمات اختصاری و اصطلاحات سئو

اصطلاحات، کلمات اختصاری و اصطلاحات سئو  ارتباط و رتبه بندی - چیست و چه عواملی بر موقعیت سایت ها در نتایج Yandex و Google تأثیر می گذارد

ارتباط و رتبه بندی - چیست و چه عواملی بر موقعیت سایت ها در نتایج Yandex و Google تأثیر می گذارد  چه عواملی بهینه سازی موتورهای جستجو بر ارتقای وب سایت تاثیر می گذارد و تا چه حد؟

چه عواملی بهینه سازی موتورهای جستجو بر ارتقای وب سایت تاثیر می گذارد و تا چه حد؟  بهینه سازی متون برای موتورهای جستجو - فراوانی بهینه کلمات کلیدی و طول ایده آل آن

بهینه سازی متون برای موتورهای جستجو - فراوانی بهینه کلمات کلیدی و طول ایده آل آن  محتوای سایت - چگونه پر کردن آن با محتوای منحصر به فرد و مفید به ارتقاء وب سایت مدرن کمک می کند

محتوای سایت - چگونه پر کردن آن با محتوای منحصر به فرد و مفید به ارتقاء وب سایت مدرن کمک می کند  عنوان، توضیحات و کلمات کلیدی متا تگ ها مانع از تبلیغ می شوند

عنوان، توضیحات و کلمات کلیدی متا تگ ها مانع از تبلیغ می شوند  به روز رسانی Yandex - آنها چه هستند، نحوه ردیابی Tits، تغییرات در نتایج جستجو و همه به روز رسانی های دیگر

به روز رسانی Yandex - آنها چه هستند، نحوه ردیابی Tits، تغییرات در نتایج جستجو و همه به روز رسانی های دیگر

یکی از اصلی ترین و مهم ترین سرویس های اینترنتی هستند.

با کمک موتورهای جستجو، میلیاردها کاربر اینترنت اطلاعات مورد نیاز خود را پیدا می کنند.

موتور جستجو چیست؟

موتور جستجو یک مجموعه نرمافزاری و سختافزاری است که از الگوریتمهای خاصی برای پردازش حجم عظیمی از اطلاعات در مورد طیف گستردهای از سایتها، محتوای آنها، تا هر صفحه استفاده میکند.

موتور جستجو از دیدگاه بازدیدکنندگان معمولی، سایت هوشمندی است که حاوی اطلاعات زیادی است و به هر گونه سوال کاربران پاسخ می دهد.

کاربران اینترنت در کشورهای مختلف از موتورهای جستجوی مختلفی استفاده می کنند. در بخش انگلیسی زبان اینترنت، محبوب ترین موتور جستجو گوگل است.

موتورهای جستجو در RuNet

در روسیه، بیش از نیمی از کاربران موتور جستجوی Yandex را ترجیح می دهند و گوگل حدود 35 درصد از درخواست ها را به خود اختصاص می دهد. سایر کاربران از خدمات Rambler، Mail.ru، Nigma و سایر خدمات استفاده می کنند.

در اوکراین، حدود 60٪ از کاربران از Google استفاده می کنند، Yandex کمی بیش از 25٪ از درخواست های پردازش شده را تشکیل می دهد.

بنابراین، هنگام تبلیغ سایت ها در Runet، متخصصان سعی می کنند سایت را با تمرکز بر موتورهای جستجو Yandex و Google تبلیغ کنند.

وظایف موتور جستجو

موتورهای جستجو برای پاسخگویی دقیق به سوالات بازدیدکنندگان باید وظایف زیر را انجام دهند:

- جمع آوری سریع و کارآمد اطلاعات در مورد صفحات مختلف سایت های مختلف.

- اطلاعات مربوط به این صفحات را پردازش کنید و تعیین کنید که با کدام پرس و جو یا پرس و جو مطابقت دارند.

- ایجاد و ارائه نتایج جستجو در پاسخ به درخواست های کاربر.

اجزای موتورهای جستجو

موتورهای جستجو مجموعه نرم افزاری پیچیده ای هستند که از بلوک های اصلی زیر تشکیل شده است:

- جمع آوری داده ها.

- نمایه سازی

- محاسبه.

- محدوده.

این تقسیم بندی مشروط است، زیرا کار موتورهای جستجوی مختلف تا حدودی با یکدیگر متفاوت است.

1. جمع آوری داده ها

در این مرحله، وظیفه یافتن اسناد جدید، برنامه ریزی برای بازدید و اسکن آنها است.

مدیران وب باید با قرار دادن آدرس صفحه در صفحه افزودنی یا پخش اعلان صفحه در شبکه های اجتماعی، موتورهای جستجو را از ظاهر مطالب جدید مطلع کنند.

من شخصاً از روش دوم استفاده می کنم و معتقدم که این کاملاً کافی است.

نظر دهید.من کمی منحرف می شوم و در مورد اثربخشی ارسال اعلان ها در شبکه های اجتماعی بر سرعت نمایه سازی صفحات جدید وب سایت صحبت می کنم.

من از سرویس text.ru برای کنترل و ثبت منحصر به فرد بودن متن در صفحات وب سایت خود استفاده می کنم.

منحصر به فرد بودن را به صورت کیفی بررسی می کند، آن را ثبت می کند و امکان قرار دادن یک بنر منحصر به فرد را در صفحات وب سایت شما فراهم می کند.

اما گاهی اوقات یک صف طولانی برای پردازش در این سرویس وجود دارد. چندین مورد داشتم که منتظر بررسی منحصر به فرد نبودم، مقاله ای را در سایت قرار دادم و آن را در شبکه های اجتماعی پخش کردم.

اگر بررسی منحصربهفرد بودن حدود یک ساعت یا بیشتر به تأخیر بیفتد، درصد منحصربهفرد بودن همیشه 0 درصد بود. این بدان معناست که در کمتر از یک ساعت پس از ارسال، صفحه از قبل ایندکس شده و وارد پایگاه داده موتور جستجو شده است.

2. نمایه سازی

موتورهای جستجو با جمع آوری داده های مربوط به صفحات وب جدید، آنها را در پایگاه داده خود قرار می دهند. در این حالت، یک شاخص تشکیل می شود، یعنی کلیدی برای دسترسی سریع به داده های مربوط به این صفحه، در صورت بروز چنین نیازی.

3. محاسبه

صفحات سایت های ما پس از ورود به پایگاه داده، مرحله محاسبه پارامترها و شاخص های مختلف را طی می کنند.

هیچ کس به جز خود توسعه دهندگان الگوریتم های موتورهای جستجو نمی تواند دقیقاً تعداد این شاخص ها و نحوه محاسبه آنها را بگوید.

4. رتبه بندی

سپس بر اساس پارامترها و شاخص های محاسبه شده، ارتباط صفحه با پرس و جوهای خاص مشخص شده و صفحه رتبه بندی می شود.

این برای تولید سریع و باکیفیت صفحات نتایج جستجو برای این پرسشها مهم است.

موتورهای جستجو به پرسش های کاربران پاسخ می دهند و در قالب صفحه نتایج جستجو برای آنها نتیجه می دهند.

لازم به ذکر است که الگوریتم های پردازش داده های صفحه، تولید شاخص ها و روش های رتبه بندی به طور مداوم در حال بهبود هستند. اولویت هایی که بر اساس آن رتبه بندی اتفاق می افتد تغییر می کند.

موتورهای جستجو سعی می کنند تا حد امکان به درخواست های کاربران پاسخ دهند و سعی می کنند ماهیت درخواست، علایق یک کاربر خاص، محل سکونت، سن، جنسیت، عادات و تمایلات او را در نظر بگیرند.

ظهر بخیر، خوانندگان عزیز وبلاگ سئو من. . این مقاله در مورد موتور جستجوی Yandex چگونه کار می کند از چه فناوریها و الگوریتمهایی برای رتبهبندی سایتها استفاده میکند و برای آمادهسازی پاسخ به کاربران چه میکند. بسیاری از مردم میدانند که این گل سرسبد جستجوی روسی، لحن را در Runet تنظیم میکند، صاحب بزرگترین پایگاه داده در اوراسیا است، محتوای بیش از یک میلیارد صفحه را مدیریت میکند و پاسخ هر سؤالی را میداند. بر اساس داده های Liveinternet برای اوت 2012، سهم Yandex در روسیه 60.5٪ است. مخاطب ماهانه پرتال 48.9 میلیون نفر است. اما مهمترین چیز برای ما وبلاگ نویسان این است که موتور جستجو چگونه درخواست های ما را دریافت می کند، چگونه آنها را پردازش می کند و در نتیجه چه نتیجه ای حاصل می شود. از یک طرف، دانستن و درک این اطلاعات استفاده از همه منابع Yandex را برای ما آسان تر می کند، از طرف دیگر، تبلیغ وبلاگ هایمان را آسان تر می کند. بنابراین، من پیشنهاد می کنم با من به مهمترین فناوری های بهترین موتور جستجوی Runet نگاه کنید.

هنگامی که یک کاربر اینترنت برای اولین بار می خواهد برای کسب اطلاعات به یک موتور جستجو مراجعه کند، ممکن است یک سوال داشته باشد: "جستجو چگونه کار می کند؟" اما هنگامی که او آن را دریافت می کند، این سؤال اغلب به سؤال دیگری تغییر می کند: "چرا اینقدر سریع؟" و به راستی چرا جستجوی فایل در کامپیوتر 20 ثانیه طول می کشد و نتیجه درخواست یک شبکه کامل از کامپیوترها در سراسر جهان در یک ثانیه ظاهر می شود؟ جالب ترین چیز این است که دو سوال اول (چگونه جستجو انجام می شود و چرا 1 ثانیه) را می توان در یک پاسخ پاسخ داد - موتور جستجو از قبل برای درخواست کاربر آماده شده است.

برای درک اصل عملکرد Yandex، مانند سایر موتورهای جستجو، بیایید یک قیاس با فهرست تلفن ترسیم کنیم. برای یافتن هر شماره تلفنی، باید نام خانوادگی مشترک را بدانید و جستجو در این مورد حداکثر یک دقیقه طول می کشد، زیرا تمام صفحات فهرست یک فهرست پیوسته الفبایی هستند. اما تصور کنید که جستجو با استفاده از گزینه دیگری انجام شود، جایی که شماره تلفن توسط خود شماره ها سفارش داده شده است. پس از چنین جستجوهایی که مدت طولانی تری ادامه خواهند داشت، اعداد برای مدت بسیار طولانی در مقابل چشمان جستجوگر باقی می مانند. 🙂

به همین ترتیب، موتور جستجو تمام اطلاعات اینترنت را به شکلی مناسب نمایش می دهد. و مهمتر از همه، همه این داده ها از قبل، قبل از اینکه بازدید کننده با درخواست های خود برسد، در فهرست راهنمای او قرار می گیرد. یعنی وقتی سوالی از یاندکس میپرسیم، از قبل پاسخ ما را میداند. و در یک ثانیه آن را به ما می دهد. اما این دوم شامل تعدادی فرآیند مهم است که اکنون به تفصیل آنها را بررسی خواهیم کرد.

نمایه سازی اینترنتی

Yandex ru تمام اطلاعاتی را که در اینترنت به دست می آورد جمع آوری می کند. با استفاده از تجهیزات ویژه، تمامی مطالب از جمله تصاویر بر اساس پارامترهای بصری بررسی می شود. موتور جستجو به چنین جمع آوری مشغول است و فرآیند جمع آوری و آماده سازی داده ها را نمایه سازی می نامند. اساس چنین ماشینی یک سیستم کامپیوتری است که در غیر این صورت ربات جستجوگر نامیده می شود. به طور منظم سایت های فهرست شده را می خزد، آنها را برای محتوای جدید بررسی می کند، و همچنین اینترنت را برای صفحات حذف شده اسکن می کند. اگر متوجه شود که چنین صفحه ای دیگر وجود ندارد یا از فهرست بندی بسته شده است، آن را از جستجو حذف می کند.

چگونه یک ربات جستجوگر سایت های جدید را پیدا می کند؟ اولا از لینک های سایت های دیگر تشکر می کنم. زیرا اگر پیوندی در یک منبع وب جدید از سایتی که قبلاً ایندکس شده است قرار داده شود، دفعه بعد که از سایت دوم بازدید می کنید، ربات از سایت اول بازدید می کند. ثانیاً، یک سرویس فوق العاده وجود دارد که به طور معمول "addurlka" نامیده می شود (از عبارت انگلیسی -addurl - آدرس را اضافه کنید). در آن می توانید آدرس سایت جدید خود را وارد کنید که پس از مدتی یک ربات جستجوگر از آن بازدید خواهد کرد. ثالثاً با کمک برنامه ویژه "Yandex.Bar" بازدید کاربرانی که از آن استفاده می کنند ردیابی می شود. بر این اساس، اگر شخصی بر روی یک منبع وب جدید قرار گیرد، به زودی یک ربات در آنجا ظاهر می شود.

آیا همه صفحات در جستجو گنجانده شده است؟ میلیون ها صفحه هر روز ایندکس می شوند. در میان آنها صفحاتی با کیفیت متفاوت وجود دارد که می تواند حاوی اطلاعات مختلفی باشد - از محتوای منحصر به فرد گرفته تا زباله کامل. علاوه بر این، همانطور که آمار می گوید، زباله های بسیار بیشتری در اینترنت وجود دارد. ربات جستجوگر هر سند را با استفاده از الگوریتم های خاص تجزیه و تحلیل می کند. تعیین می کند که آیا اطلاعات مفیدی دارد و آیا می تواند به درخواست کاربر پاسخ دهد یا خیر. اگر نه، پس چنین صفحاتی به عنوان "کیهان نورد" پذیرفته نمی شوند، اما اگر چنین است، در جستجو گنجانده می شود.

پس از اینکه یک ربات از یک صفحه بازدید کرد و سودمندی آن را مشخص کرد، در فضای ذخیره سازی موتور جستجو ظاهر می شود. در اینجا ما هر سندی را تا اصول اولیه تجزیه و تحلیل می کنیم، همانطور که استادان مرکز خودکار می گویند - تا چرخ دنده ها. صفحه از نشانه گذاری html پاک می شود، متن تمیز یک موجودی کامل را پشت سر می گذارد - مکان هر کلمه محاسبه می شود. در این فرم جدا شده، صفحه به جدولی با اعداد و حروف تبدیل می شود که در غیر این صورت فهرست نامیده می شود. اکنون، مهم نیست که چه اتفاقی برای منبع وب حاوی این صفحه می افتد، آخرین نسخه آن همیشه در جستجو موجود است. حتی اگر سایت دیگر وجود نداشته باشد، نسخه هایی از اسناد آن برای مدتی در اینترنت ذخیره می شود.

هر شاخص، همراه با داده های مربوط به انواع سند، رمزگذاری، زبان، همراه با کپی ها را تشکیل می دهند پایگاه داده جستجو . به طور دوره ای به روز می شود، بنابراین در سرورهای خاصی قرار دارد که با کمک آنها درخواست های کاربران موتور جستجو پردازش می شود.

فرآیند نمایه سازی هر چند وقت یکبار اتفاق می افتد؟ اول از همه به نوع سایت ها بستگی دارد. منبع وب نوع اول محتوای صفحات خود را اغلب تغییر می دهد. یعنی وقتی هر بار یک ربات جستجوگر به این صفحات می آید، هر بار محتوای متفاوتی دارند. دفعه بعد نمی توانید با استفاده از آنها چیزی پیدا کنید، بنابراین چنین سایت هایی در فهرست قرار نمی گیرند. نوع دوم سایت یک انبار داده است که در صفحات آن به صورت دوره ای پیوندهایی به اسناد برای دانلود اضافه می شود. محتوای چنین سایتی معمولاً تغییر نمی کند، بنابراین ربات به ندرت از آن بازدید می کند. سایت های دیگر به دفعات به روز رسانی مطالب بستگی دارند. این به این معنی است: هر چه محتوای جدید سریعتر در سایت ظاهر شود، ربات جستجوگر بیشتر می آید. و اولویت اول به مهم ترین منابع وب داده می شود (مثلاً یک سایت خبری از هر وبلاگی اهمیت بیشتری دارد).

نمایه سازی به شما امکان می دهد اولین عملکرد یک موتور جستجو را انجام دهید - جمع آوری اطلاعات در صفحات جدید در اینترنت. اما Yandex یک عملکرد دوم نیز دارد - جستجوی پاسخ به درخواست کاربر در یک پایگاه داده جستجوی از قبل آماده شده.

Yandex در حال آماده سازی پاسخ است

فرآیند رسیدگی به درخواست و صدور پاسخ های مربوطه توسط سیستم کامپیوتری "متاسرچ" . برای کار خود، ابتدا تمام اطلاعات ورودی را جمع آوری می کند: درخواست از چه منطقه ای انجام شده است، به چه کلاسی تعلق دارد، آیا خطاهایی در درخواست وجود دارد و غیره. پس از چنین پردازشی، metasearch بررسی می کند که آیا دقیقاً همان پرس و جوها با پارامترهای یکسان در پایگاه داده وجود دارد یا خیر. اگر پاسخ مثبت است، سیستم نتایج ذخیره شده قبلی را به کاربر نشان می دهد. اگر چنین سوالی در پایگاه داده وجود نداشته باشد، metasearch به پایگاه داده جستجویی که حاوی داده های فهرست است، می پردازد.

و اینجاست که اتفاقات شگفت انگیزی رخ می دهد. تصور کنید که یک کامپیوتر فوق العاده قدرتمند وجود دارد که کل اینترنت پردازش شده توسط روبات های جستجوگر را ذخیره می کند. کاربر یک پرس و جو تنظیم می کند و جستجو در سلول های حافظه برای همه اسناد درگیر در پرس و جو آغاز می شود. جواب پیدا شد و همه خوشحال شدند. اما بیایید یک مورد دیگر را در نظر بگیریم، زمانی که درخواست های زیادی حاوی همان کلمات در بدن آنها وجود دارد. سیستم باید هر بار از سلول های حافظه یکسانی عبور کند که می تواند زمان پردازش داده ها را به میزان قابل توجهی افزایش دهد. بر این اساس، زمان افزایش می یابد، که می تواند منجر به از دست دادن کاربر شود - او برای کمک به موتور جستجوی دیگری مراجعه می کند.

برای جلوگیری از چنین تاخیرهایی، تمام نسخههای موجود در فهرست سایت در رایانههای مختلف توزیع میشوند. پس از ارسال درخواست، metasearch به چنین سرورهایی دستور می دهد که قطعه متن خود را جستجو کنند. پس از آن، تمام داده های این ماشین ها به کامپیوتر مرکزی بازگردانده می شود، تمام نتایج به دست آمده را ترکیب می کند و ده پاسخ برتر را به کاربر می دهد. با این فناوری، دو پرنده با یک سنگ کشته میشوند: زمان جستجو چندین بار کاهش مییابد (پاسخ در کسری از ثانیه به دست میآید) و به لطف افزایش پلت فرمها، اطلاعات تکراری میشوند (دادهها به دلیل خرابی ناگهانی از بین نمیروند. ). خود رایانه ها با اطلاعات تکراری یک مرکز داده را تشکیل می دهند - این یک اتاق با سرورها است.

هنگامی که کاربر موتور جستجو یک پرس و جو می پرسد، 20 بار از 100، نتایج در سوال مبهم هستند. به عنوان مثال، اگر او کلمه "ناپلئون" را در نوار جستجو بنویسد، هنوز معلوم نیست که چه پاسخی را انتظار دارد - دستور پخت کیک یا بیوگرافی فرمانده بزرگ. یا عبارت "برادران گریم" - افسانه ها، فیلم ها، گروه موسیقی. Yandex برای محدود کردن چنین طیف ممکنی از اهداف به پاسخ های خاص، یک فناوری ویژه دارد S p e c t r. با استفاده از آمار پرس و جو نیازهای کاربر را در نظر می گیرد. از بین تمام سوالاتی که بازدیدکنندگان در Yandex پرسیده اند، Spectrum اشیاء مختلفی را در آنها شناسایی می کند (نام افراد، عنوان کتاب ها، مدل های ماشین و غیره) این اشیاء در دسته های خاصی توزیع می شوند. در حال حاضر بیش از 60 دسته از این دست وجود دارد. با کمک آنها، موتور جستجو در پایگاه داده خود معانی مختلفی از کلمات در جستجوهای کاربر را دارد. جالب توجه است که این دسته ها به صورت دوره ای بررسی می شوند (تجزیه و تحلیل چند بار در هفته انجام می شود)، که به Yandex اجازه می دهد تا با دقت بیشتری به سوالات مطرح شده پاسخ دهد.

بر اساس فناوری Spectrum، Yandex دستورات گفتگو را سازماندهی کرد. آنها در زیر نوار جستجو ظاهر می شوند که در آن کاربر درخواست مبهم خود را تایپ می کند. این خط نشان دهنده دسته بندی هایی است که موضوع سوال ممکن است به آن تعلق داشته باشد. نتایج جستجوی بیشتر به انتخاب کاربر از این دسته بستگی دارد.

از 15 تا 30 درصد از همه کاربران موتور جستجوی Yandex می خواهند فقط اطلاعات محلی (داده های منطقه ای که در آن زندگی می کنند) دریافت کنند. مثلا در مورد فیلم های جدید در سینماهای شهر شما. بنابراین، پاسخ به چنین درخواستی باید برای هر منطقه متفاوت باشد. در این راستا، Yandex از فناوری خود استفاده می کند جستجو بر اساس مناطق

. به عنوان مثال، اینها پاسخ هایی است که ساکنانی که به دنبال رپرتوار فیلم در سینمای اکتیابر خود هستند ممکن است دریافت کنند:

از 15 تا 30 درصد از همه کاربران موتور جستجوی Yandex می خواهند فقط اطلاعات محلی (داده های منطقه ای که در آن زندگی می کنند) دریافت کنند. مثلا در مورد فیلم های جدید در سینماهای شهر شما. بنابراین، پاسخ به چنین درخواستی باید برای هر منطقه متفاوت باشد. در این راستا، Yandex از فناوری خود استفاده می کند جستجو بر اساس مناطق

. به عنوان مثال، اینها پاسخ هایی است که ساکنانی که به دنبال رپرتوار فیلم در سینمای اکتیابر خود هستند ممکن است دریافت کنند:

اما این نتیجه ای است که ساکنان شهر استاوروپل برای همین درخواست دریافت خواهند کرد:

منطقه کاربر در درجه اول با آدرس IP آن تعیین می شود. گاهی اوقات این داده ها دقیق نیستند، زیرا تعدادی از ارائه دهندگان می توانند همزمان در چندین منطقه کار کنند و بنابراین آدرس IP کاربران خود را تغییر دهند. در اصل، اگر این اتفاق برای شما بیفتد، می توانید به راحتی منطقه خود را در تنظیمات موتور جستجو تغییر دهید. در گوشه سمت راست بالای صفحه نتایج فهرست شده است. می توانید آن را تغییر دهید.

موتور جستجو Yandex ru - نتایج پاسخ

وقتی Metasearch پاسخی را آماده کرد، موتور جستجوی Yandex باید آن را در صفحه نتایج نمایش دهد. این لیستی از پیوندها به اسناد یافت شده با اطلاعات کمی در مورد هر یک است. وظیفه فناوری صدور نتایج این است که مرتبط ترین پاسخ ها را به آموزنده ترین روش در اختیار کاربر قرار دهد. الگوی یکی از این پیوندها به شکل زیر است:

بیایید به این شکل از نتیجه با جزئیات بیشتری نگاه کنیم. برای عنوان نتیجه جستجو Yandex اغلب از نام عنوان صفحه (آنچه بهینه سازها در برچسب عنوان می نویسند) استفاده می کند. اگر وجود ندارد، کلمات عنوان مقاله یا پست در اینجا ظاهر می شوند. اگر متن عنوان بزرگ باشد، موتور جستجو بخشی را که بیشترین ارتباط را با پرس و جو داده شده دارد، در این قسمت قرار می دهد.

خیلی به ندرت، اما اتفاق می افتد که عنوان با محتوای درخواست مطابقت ندارد. در این مورد، Yandex عنوان نتیجه جستجوی خود را با استفاده از متن موجود در مقاله یا پست تشکیل می دهد. قطعا کلمات پرس و جو خواهد داشت.

برای قطعهموتور جستجو از تمام متن های موجود در صفحه استفاده می کند. تمام قطعاتی را که پاسخ پرس و جو وجود دارد انتخاب می کند و سپس مرتبط ترین مورد را انتخاب می کند و پیوندهای سند را در فیلد فرم درج می کند. به لطف این رویکرد، یک بهینه ساز توانمند می تواند پس از دیدن یک قطعه آن را بازسازی کند و در نتیجه جذابیت پیوند را بهبود بخشد.

برای درک بهتر نتیجه درخواست کاربر، عناوین به صورت پیوندهایی در متن قالب بندی می شوند (به رنگ آبی با زیر خط برجسته شده اند). برای جذاب و قابل تشخیص کردن منبع وب، یک فاویکون اضافه می شود - یک نماد سایت با مارک کوچک. در سمت چپ متن در خط اول قبل از عنوان ظاهر می شود. تمام کلماتی که در درخواست در پاسخ گنجانده شده اند نیز برای سهولت درک با خط پررنگ مشخص شده اند.

اخیراً موتور جستجوی Yandex اطلاعات مختلفی را به قطعه اضافه می کند که به کاربر کمک می کند تا پاسخ خود را سریعتر و دقیق تر پیدا کند. به عنوان مثال، اگر کاربری نام سازمانی را در درخواست خود بنویسد، Yandex آدرس، شماره تماس و پیوندی به مکان موجود در نقشه های جغرافیایی را در قطعه اضافه می کند. اگر موتور جستجو با ساختار سایت که حاوی یک سند با پاسخ برای کاربر است آشنا باشد، قطعا آن را نشان می دهد. به علاوه، Yandex می تواند بلافاصله بیشترین بازدید از چنین منبع وب را به قطعه اضافه کند تا در صورت تمایل، بازدیدکننده بتواند بلافاصله به بخش مورد نیاز خود رفته و در وقت خود صرفه جویی کند.

تکه هایی وجود دارد که شامل قیمت یک محصول برای یک فروشگاه آنلاین، رتبه بندی هتل یا رستوران به شکل ستاره و سایر اطلاعات جالب با اعداد مختلف در مورد اشیاء در اسناد جستجو است. هدف از چنین اطلاعاتی ارائه لیست کاملی از داده ها در مورد موارد یا اشیایی است که مورد علاقه کاربر هستند.

به طور کلی، با مثال های مختلف، صفحه با پاسخ به این شکل خواهد بود:

رتبه بندی و ارزیابان

وظیفه Yandex نه تنها شامل جستجوی همه گزینه های پاسخ ممکن، بلکه انتخاب بهترین (مرتبط) است. از این گذشته ، کاربر تمام پیوندهایی را که Yandex به عنوان نتیجه جستجو در اختیار او قرار می دهد ، جستجو نمی کند. فرآیند سازماندهی نتایج جستجو نامیده می شود رتبه بندی . یعنی این رتبه بندی است که کیفیت پاسخ های پیشنهادی را تعیین می کند.

قوانینی وجود دارد که توسط Yandex صفحات مربوطه را تعیین می کند:

- سایت هایی که کیفیت جستجو را پایین می آورند در موقعیت های صفحه نتایج کاهش می یابند. معمولاً اینها منابع وب هستند که صاحبان آنها سعی در فریب موتور جستجو دارند. به عنوان مثال، اینها سایت هایی با صفحات حاوی متن بی معنی یا نامرئی هستند. البته، برای یک ربات جستجوگر قابل مشاهده و درک است، اما برای بازدیدکننده ای که این سند را می خواند، قابل درک نیست. یا سایت هایی که با کلیک بر روی یک لینک در قسمت نتایج جستجو، بلافاصله کاربر را به سایتی کاملا متفاوت منتقل می کنند.

- سایت های حاوی محتوای وابسته به عشق شهوانی در نتایج گنجانده نشده اند یا در رتبه بندی بسیار کاهش یافته اند. این به دلیل این واقعیت است که چنین منابع وب اغلب از روش های تبلیغاتی تهاجمی استفاده می کنند.

- سایتهای آلوده به ویروس در نتایج جستجو پایین نمیآیند و از نتایج جستجو مستثنی نمیشوند - در این حالت، کاربر با استفاده از یک نماد خاص از خطر مطلع میشود. این به دلیل این واقعیت است که Yandex فرض می کند که چنین منابع وب ممکن است حاوی اسناد مهمی به درخواست بازدید کننده موتور جستجو باشد.

به عنوان مثال، Yandex به این صورت است که سایت ها را برای پرس و جو "apple" رتبه بندی می کند:

علاوه بر فاکتورهای رتبهبندی، Yandex از نمونههای ویژه با پرسشها و پاسخهایی استفاده میکند که کاربران موتورهای جستجو مناسبترین آنها را در نظر میگیرند. در حال حاضر هیچ ماشینی نمی تواند چنین نمونه هایی را بسازد - این حق انسان است. در Yandex، چنین متخصصانی نامیده می شوند ارزیابان. وظیفه آنها تجزیه و تحلیل کامل تمام اسناد جستجو و ارزیابی پاسخ به سؤالات مشخص شده است. آنها بهترین پاسخ ها را انتخاب می کنند و یک مجموعه آموزشی ویژه ایجاد می کنند. در آن، موتور جستجو رابطه بین صفحات مرتبط و ویژگی های آنها را می بیند. Yandex با داشتن چنین اطلاعاتی می تواند فرمول رتبه بندی بهینه را برای هر درخواست انتخاب کند. روش ساخت چنین فرمولی Matrixnet نام دارد. مزیت این سیستم این است که در برابر بیش از حد مقاوم است که به شما امکان می دهد تعداد زیادی از عوامل رتبه بندی را بدون افزایش تعداد رتبه بندی ها و الگوهای غیر ضروری در نظر بگیرید.

در پایان پست خود، می خواهم آمار جالبی را که توسط موتور جستجوی Yandex در طول کار خود جمع آوری شده است، به شما نشان دهم.

1. محبوبیت نام های شخصی در روسیه و شهرهای روسیه (داده های گرفته شده از حساب های وبلاگ نویسان و کاربران شبکه های اجتماعی در مارس 2012).

در سال 1863، نویسنده بزرگ ژول ورن کتاب بعدی خود را با عنوان "پاریس در قرن بیستم" خلق کرد. او در آن به تفصیل مترو، ماشین، صندلی برقی، کامپیوتر و حتی اینترنت را توضیح داد. با این حال، ناشر از چاپ کتاب خودداری کرد و بیش از 120 سال در آنجا ماند تا اینکه توسط نوه ژول ورن در سال 1989 پیدا شد. این کتاب در سال 1994 منتشر شد.

در سال 1863، نویسنده بزرگ ژول ورن کتاب بعدی خود را با عنوان "پاریس در قرن بیستم" خلق کرد. او در آن به تفصیل مترو، ماشین، صندلی برقی، کامپیوتر و حتی اینترنت را توضیح داد. با این حال، ناشر از چاپ کتاب خودداری کرد و بیش از 120 سال در آنجا ماند تا اینکه توسط نوه ژول ورن در سال 1989 پیدا شد. این کتاب در سال 1994 منتشر شد.

ژوئیه گذشته، ایلیا سگالویچ درگذشت، بنیانگذار و مدیر فناوری در Yandex، خالق اولین نسخه موتور جستجو و نویسنده نام آن. به یاد این شخص برجسته و چهره عمومی که به بسیاری از جمله کمک کردکلتا. RU، ما آن را در مورد بازیابی اطلاعات و مدل های ریاضی زیربنای آن بازنشر می کنیم. ایلیا سگالویچ موتورهای جستجو را یکی از دو عجایب جدید جهان نامید. در هر صورت، بدون آنها، از جمله بدون خلاقیت اصلی سگالوویچ، Yandex، زندگی ما کاملاً متفاوت خواهد بود.

صدها موتور جستجو در دنیا نوشته شده اند و اگر توابع جستجوی پیاده سازی شده در برنامه های مختلف را بشمارید، باید هزاران نفر را بشمارید. و مهم نیست که فرآیند جستجو چگونه اجرا می شود، مهم نیست که بر اساس چه مدل ریاضی است، ایده ها و برنامه هایی که جستجو را پیاده سازی می کنند بسیار ساده هستند. اگرچه این سادگی ظاهراً متعلق به دسته ای است که در مورد آن می گویند "ساده است، اما کار می کند". به هر شکلی، این موتورهای جستجو بودند که به یکی از دو عجایب جدید جهان تبدیل شدند هموsapiensدسترسی نامحدود و فوری به اطلاعات بدیهی است که اولین معجزه را می توان اینترنت با قابلیت های آن برای ارتباطات جهانی دانست.

موتورهای جستجو از دیدگاه تاریخی

یک باور رایج وجود دارد که هر نسل جدید نرم افزار از نسل قبلی پیشرفته تر است. آنها می گویند که قبلا همه چیز ناقص بود، اما اکنون هوش مصنوعی در همه جا حاکم است. دیدگاه افراطی دیگر این است که "هر چیز جدید به خوبی فراموش شده قدیمی است." من فکر می کنم که وقتی صحبت از موتورهای جستجو می شود، حقیقت جایی در وسط است.

اما در واقع چه چیزی در سال های اخیر تغییر کرده است؟ نه الگوریتم ها یا ساختارهای داده، نه مدل های ریاضی. اگرچه آنها نیز. پارادایم استفاده از سیستم ها تغییر کرده است. به عبارت ساده، یک زن خانه دار به دنبال اتوی ارزان تر و فارغ التحصیل یک مدرسه شبانه روزی کمکی به امید یافتن شغلی به عنوان مکانیک خودرو، پشت صفحه نمایش با خط جستجو نشست. علاوه بر ظهور عاملی که در دوران پیش از اینترنت غیرممکن بود - عامل تقاضای کل برای موتورهای جستجو - چند تغییر دیگر آشکار شد. اول، مشخص شد که مردم نه تنها "در کلمات فکر می کنند"، بلکه "در کلمات جستجو می کنند." آنها انتظار دارند کلمه تایپ شده در query string را در پاسخ سیستم ببینند. و ثانیاً: «آموزش مجدد جستجو به سالک» دشوار است، همانطور که بازآموزی گفتن یا نوشتن دشوار است. رویاهای دهه 60 تا 80 در مورد اصلاح تکراری پرس و جوها، در مورد درک زبان طبیعی، در مورد جستجو بر اساس معنا، در مورد ایجاد یک پاسخ منسجم برای یک سوال، اکنون به سختی در آزمون واقعیت مقاومت می کنند.

الگوریتم + ساختار داده = موتور جستجو

مانند هر برنامه دیگری، یک موتور جستجو بر روی ساختارهای داده کار می کند و یک الگوریتم را اجرا می کند. تنوع الگوریتم ها زیاد نیست، اما وجود دارد. بدون احتساب کامپیوترهای کوانتومی، که به ما نوید یک پیشرفت جادویی در "پیچیدگی الگوریتمی" جستجو را می دهند و نویسنده تقریباً چیزی در مورد آنها نمی داند، چهار دسته از الگوریتم های جستجو وجود دارد. سه الگوریتم از هر چهار الگوریتم به "نمایه سازی"، پردازش اولیه اسناد نیاز دارند، که در طی آن یک فایل کمکی ایجاد می شود، یعنی یک "نمایه" که برای ساده سازی و سرعت بخشیدن به جستجو طراحی شده است. اینها الگوریتم هایی برای فایل های معکوس، درختان پسوند و امضا هستند. در مورد منحط، هیچ مرحله نمایه سازی اولیه وجود ندارد و جستجو با استفاده از اسکن متوالی اسناد انجام می شود. این جستجو مستقیم نامیده می شود.

جستجوی مستقیم

ساده ترین نسخه آن برای بسیاری آشناست و هیچ برنامه نویسی وجود ندارد که حداقل یک بار در زندگی خود کد مشابهی را ننوشته باشد:

با وجود سادگی ظاهری، جستجوی مستقیم در 30 سال گذشته به شدت در حال توسعه بوده است. تعداد قابل توجهی از ایده ها ارائه شده است که زمان جستجو را چندین بار کاهش می دهد. این الگوریتم ها در ادبیات مختلف به تفصیل شرح داده شده اند. بررسی های خوبی از روش های جستجوی مستقیم را می توان در کتاب های درسی یافت، به عنوان مثال، توسط Sedgwick یا Corman. باید در نظر داشت که الگوریتم های جدید و نسخه های بهبود یافته آنها به طور مداوم ظاهر می شوند.

اگرچه اسکن مستقیم همه متون کار نسبتاً کندی است، نباید فکر کرد که الگوریتمهای جستجوی مستقیم در اینترنت استفاده نمیشوند. موتور جستجوی نروژی سریعاز تراشه ای استفاده کرد که منطق جستجوی مستقیم برای عبارات منظم ساده شده را پیاده سازی می کند (fastpmc) ، و 256 تراشه از این قبیل را روی یک برد قرار داد. این اجازه داد سریعتعداد نسبتاً زیادی درخواست در واحد زمان ارائه می شود.

علاوه بر این، برنامه های زیادی وجود دارند که جستجوی فهرست را برای یافتن یک بلوک متن با جستجوی مستقیم بیشتر در داخل بلوک ترکیب می کنند. به عنوان مثال، بسیار محبوب، از جمله در RuNet، نگاه اجمالی.

به طور کلی، الگوریتم های مستقیم اساساً ویژگی های متمایز برد-برد دارند. به عنوان مثال، امکانات نامحدود برای جستجوی تقریبی و فازی. از این گذشته ، هر نمایه سازی همیشه با ساده سازی و عادی سازی اصطلاحات و در نتیجه با از دست دادن اطلاعات همراه است. جستجوی مستقیم مستقیماً از اسناد اصلی و بدون هیچ گونه تحریف کار می کند.

فایل وارونه

این سادهترین ساختار داده، علیرغم نام خارجی مرموزش، هم برای هر فرد باسواد و هم برای هر برنامهنویس پایگاهدادهای که حتی با جستجوی متن کامل سروکار نداشته است، به طور مستقیم آشناست. دسته اول از مردم با "تطابق" می دانند که چیست - فهرست های جامعی از کلمات به ترتیب حروف الفبا از یک متن یا متعلق به یک نویسنده (به عنوان مثال، "همخوانی با اشعار A.S. پوشکین"، "لغت نامه-مطابق روزنامه نگاری توسط F.M. داستایوفسکی"). این دومی هر زمان که یک «شاخص پایگاه داده در یک فیلد کلیدی» ایجاد کرده یا از آن استفاده میکند، با نوعی فهرست معکوس سروکار دارد.

اجازه دهید این ساختار را با کمک یک همخوانی فوق العاده روسی - "سمفونی" که توسط پدرسالار مسکو بر اساس متن ترجمه سینودال کتاب مقدس منتشر شده است، نشان دهیم.

در اینجا فهرستی از کلمات به ترتیب حروف الفبا آمده است. برای هر کلمه، تمام «موقعیتهایی» که این کلمه در آن رخ داده است، فهرست شدهاند. الگوریتم جستجو شامل یافتن کلمه مورد نظر و بارگذاری لیستی از موقعیت های موجود در حافظه است.

برای صرفه جویی در فضای دیسک و افزایش سرعت جستجو معمولا از دو تکنیک استفاده می شود. در مرحله اول، می توانید در جزئیات خود موقعیت صرفه جویی کنید. از این گذشته، هرچه چنین موقعیتی با جزئیات بیشتری مشخص شود (مثلاً در مورد "سمفونی" "کتاب + فصل + بیت" است) فضای بیشتری برای ذخیره پرونده وارونه نیاز خواهد بود.

در دقیقترین نسخه، فایل وارونه میتواند شماره کلمه، افست در بایت از ابتدای متن، رنگ و اندازه فونت و موارد دیگر را ذخیره کند. بیشتر اوقات، آنها به سادگی شماره سند (مثلاً یک کتاب کتاب مقدس) و تعداد دفعاتی که این کلمه در آن استفاده شده است را نشان می دهند. این ساختار ساده شده است که در نظریه کلاسیک بازیابی اطلاعات اساسی در نظر گرفته می شود - اطلاعاتبازیابی(IR) .

روش فشرده سازی دوم (به هیچ وجه به روش اول مربوط نمی شود): موقعیت های هر کلمه را به ترتیب صعودی آدرس مرتب کنید و برای هر موقعیت آدرس کامل آن را ذخیره نکنید، بلکه تفاوت آن با قبلی را ذخیره کنید. چنین لیستی برای صفحه ما به نظر می رسد، با فرض اینکه موقعیت را تا شماره فصل به خاطر بسپاریم:

علاوه بر این، برخی از روشهای بستهبندی ساده بر روی روش دیفرانسیل ذخیرهسازی آدرسها اضافه شده است: چرا تعداد ثابتی از بایتها را به یک عدد صحیح کوچک میدهید، زیرا میتوانید تقریباً به اندازهای که شایسته است، به آن تعداد بایت بدهید. در اینجا مناسب است به کدهای Golomb یا یک تابع داخلی یک زبان محبوب اشاره کنیم پرل: بسته(«و») .

در ادبیات نیز توپخانه سنگینتری از الگوریتمهای بستهبندی گستردهتر وجود دارد: حساب، هافمن، LZWو غیره پیشرفت در این زمینه ادامه دارد. در عمل، آنها به ندرت در موتورهای جستجو مورد استفاده قرار می گیرند: دستاوردها اندک است، و قدرت پردازنده به طور ناکارآمد استفاده می شود.

در نتیجه تمام ترفندهای توصیف شده، اندازه فایل معکوس بسته به جزئیات آدرس دهی معمولاً بین 7 تا 30 درصد اندازه متن اصلی است.

در کتاب قرمز ذکر شده است

الگوریتمها و ساختارهای دادهای غیر از جستجوی معکوس و مستقیم بارها پیشنهاد شدهاند. اینها، اول از همه، درختان پسوندی (مانبر، گوننت)، و همچنین امضاها (فالوتسوس) هستند.

اولین مورد از آنها همچنین در اینترنت کار می کرد، که یک الگوریتم موتور جستجوی ثبت شده بود متن باز. من در موتورهای جستجوی داخلی با پسوند ایندکس مواجه شده ام. روش دوم، روش امضا، شامل تبدیل یک سند به جداول بلوک به بلوک مقادیر هش کلمات آن - یک "امضا" و اسکن متوالی "امضاها" در طول جستجو است.

هیچ کدام از این روش ها به طور گسترده مورد استفاده قرار نگرفتند، و بنابراین سزاوار بحث مفصل در این مقاله کوتاه نبودند.

مدل های ریاضی

از هر پنج موتور جستجو و ماژول تقریباً سه مورد بدون هیچ مدل ریاضی کار می کنند. به طور دقیق تر، توسعه دهندگان آنها وظیفه اجرای یک مدل انتزاعی را برای خود تعیین نمی کنند و/یا از وجود آن آگاه نیستند. اصل در اینجا ساده است: تا زمانی که برنامه حداقل چیزی را پیدا کند. به هر حال. و سپس خود کاربر متوجه خواهد شد.

با این حال، به محض اینکه صحبت از بهبود کیفیت جستجو، در مورد حجم زیادی از اطلاعات، در مورد جریان درخواستهای کاربران، علاوه بر ضرایب تجربی تعیینشده به میان میآید، به نظر میرسد که کار با برخی موارد، هرچند ساده، نظری مفید است. دستگاه یک مدل جستجو ساده سازی خاصی از واقعیت است که بر اساس آن فرمولی به دست می آید (به خودی خود برای هر کسی بی فایده) که به برنامه اجازه می دهد تصمیم بگیرد: کدام سند یافت شده در نظر گرفته می شود و چگونه آن را رتبه بندی می کند. پس از پذیرش مدل، ضرایب اغلب معنای فیزیکی پیدا میکنند و برای خود توسعهدهنده واضحتر میشوند و انتخاب آنها جالبتر میشود.

انواع مدل های جستجوی اطلاعات سنتی (IR) معمولاً به سه نوع تقسیم می شود: مجموعه-نظری (بولی، مجموعه های فازی، بولی توسعه یافته)، جبری (بردار، بردار تعمیم یافته، معنایی پنهان، شبکه عصبی) و احتمالاتی.

خانواده مدل های Boolean در واقع اولین مدلی است که برای برنامه نویسی که جستجوی تمام متن را اجرا می کند به ذهن می رسد. اگر کلمه ای وجود داشته باشد - سند پیدا شده در نظر گرفته می شود، اگر نه - یافت نشد. در واقع، مدل کلاسیک بولی پلی است که نظریه بازیابی اطلاعات را با تئوری جستجو و دستکاری داده ها متصل می کند.

انتقادی که به مدل بولین که کاملاً منصفانه است، این است که برای رتبه بندی فوق العاده سفت و سخت و نامناسب است. بنابراین، در سال 1957، جویس و نیدهام پیشنهاد کردند که ویژگیهای بسامد کلمات را در نظر بگیرند، به طوری که "... عملیات مقایسه، نسبتی از فاصله بین بردارها باشد..." (جویس، 1957). مدل برداری در سال 1968 توسط بنیانگذار علم بازیابی اطلاعات، جرارد سالتون، با موفقیت اجرا شد. (جراردسالتون) در موتور جستجو SMART(سالتون"سجادوییخودکاررتریورازمتن) .

رتبه بندی در این مدل بر اساس مشاهدات آماری طبیعی است که هر چه فراوانی محلی یک عبارت در یک سند بالاتر باشد. (TF) و «نادر بودن» بیشتر (یعنی وقوع معکوس در اسناد) این اصطلاح در مجموعه (ارتش اسرائیل) ، وزن این سند نسبت به اصطلاح بیشتر است. تعیین ارتش اسرائیلکارن اسپارک جونز در سال 1972 در مقاله ای درباره قدرت متمایز معرفی کرد (مدتخاص بودن) . از این به بعد تعیین TF* ارتش اسرائیلبه طور گسترده به عنوان مترادف برای مدل برداری استفاده می شود.

سرانجام، در سال 1977، رابرتسون و اسپارک جونز یک مدل احتمالی (پیشنهاد شده در سال 1960 (مارون)) را توجیه و اجرا کردند که پایه و اساس یک خانواده کامل را نیز بنا نهاد. ارتباط در این مدل به عنوان احتمال اینکه یک سند معین ممکن است مورد علاقه کاربر باشد در نظر گرفته می شود. این به معنای وجود یک مجموعه اولیه موجود از اسناد مربوطه است که توسط کاربر انتخاب شده یا به طور خودکار تحت برخی فرضیات ساده به دست آمده است. احتمال مرتبط بودن برای هر سند بعدی بر اساس نسبت وقوع اصطلاحات در مجموعه مربوطه و در بقیه بخش "بی ربط" مجموعه محاسبه می شود. اگرچه مدلهای احتمالی دارای برخی مزیتهای نظری هستند - آنها اسناد را به ترتیب نزولی از نظر "احتمال مرتبط بودن" رتبهبندی میکنند - هرگز در عمل جذابیت زیادی به دست نیاوردهاند.

من قصد ندارم وارد جزئیات شوم و فرمول های دست و پا گیر را برای هر مدل بنویسم. خلاصه آنها، همراه با یک بحث، 35 صفحه را به صورت فشرده در کتاب "بازیابی اطلاعات مدرن" (Baeza-Yates) می گیرد. فقط توجه به این نکته مهم است که در هر یک از خانواده ها ساده ترین مدل مبتنی بر فرض استقلال متقابل کلمات است و یک شرط فیلتر ساده دارد: اسنادی که حاوی کلمه پرس و جو نیستند هرگز یافت نمی شوند. مدلهای پیشرفته («جایگزین») هر یک از خانوادهها، کلمات پرس و جو را مستقل از یکدیگر در نظر نمیگیرند و علاوه بر این، به شما امکان میدهند اسنادی را بیابید که حاوی یک کلمه از پرس و جو نیستند.

جستجوی "بر اساس معنی"

توانایی یافتن و رتبه بندی اسنادی که حاوی کلمات پرس و جو نیستند، اغلب نشانه هوش مصنوعی یا جستجو بر اساس معنا در نظر گرفته می شود و به طور پیشینی به مزایای مدل نسبت داده می شود. ما این سوال را که آیا این درست است یا خیر خارج از حوصله این مقاله می گذاریم.

به عنوان مثال، من فقط یک مدل، شاید محبوب ترین، را توصیف می کنم که به روشی معنادار کار می کند. در نظریه بازیابی اطلاعات، این مدل را معمولاً نمایه سازی معنایی پنهان (به عبارت دیگر شناسایی معانی پنهان) می نامند. این مدل جبری بر اساس تجزیه ارزش مفرد یک ماتریس مستطیلی است که کلمات را با اسناد مرتبط می کند. یک عنصر ماتریس یک پاسخ فرکانسی است که میزان ارتباط بین یک کلمه و یک سند را نشان می دهد، به عنوان مثال، TF* ارتش اسرائیل. به جای ماتریس میلیون بعدی اصلی، نویسندگان روش Furnas و Dirvester استفاده از 50-150 "معنای پنهان" را پیشنهاد کردند که مربوط به اولین اجزای اصلی تجزیه منفرد آن است.

تجزیه مفرد یک ماتریس واقعی الفاندازه ها متر*نهر تجزیه فرم نامیده می شود الف=USV، کجا U متر* متر, V - ماتریس اندازه متعامد n*ن, اس- ماتریس اندازه مورب متر*ن، که عناصر آن sij = 0 ، اگر منبرابر نیست j، و sii=سی >= 0 . مقادیر siمقادیر منفرد ماتریس نامیده می شوند و برابر با مقادیر حسابی ریشه های مربع مقادیر ویژه ماتریس هستند. AAT. در ادبیات انگلیسی زبان معمولاً تجزیه مفرد نامیده می شود SVD-تجزیه

خیلی وقت پیش (اکارت) ثابت شد که اگر اولی را رها کنیم کاعداد مفرد (بقیه را برابر با صفر کنید)، نزدیکترین تقریب ممکن را از ماتریس رتبه اصلی بدست می آوریم. ک(به یک معنا، «نزدیک ترین تفسیر معنایی آن از رتبه ک"). با کاهش رتبه، جزئیات نامربوط را فیلتر می کنیم. با افزایش، سعی می کنیم تمام تفاوت های ظریف ساختار داده های واقعی را منعکس کنیم.

عملیات جستجو یا یافتن اسناد مشابه بسیار ساده شده است، زیرا هر کلمه و هر سند با بردار نسبتاً کوتاهی مرتبط است. کمعانی (ردیف ها و ستون های ماتریس های مربوطه). اما به دلیل معنی نداشتن «معانی» یا به دلایل دیگر، اما استفاده LSIدر پیشانی برای جستجو هرگز گسترده نشد. اگرچه برای اهداف کمکی (فیلتر کردن خودکار، طبقه بندی، جداسازی مجموعه ها، کاهش ابعاد اولیه برای سایر مدل ها)، این روش ظاهراً کاربرد پیدا می کند.

ارزیابی کیفیت

... تست استحکام نشان داد که همپوشانی اسناد مربوطه بین هر دو ارزیاب به طور متوسط تقریباً 40٪ بود.<...>دقت و یادآوری اندازه گیری شده بین ارزیابان، حدود 65%<...>این یک محدودیت عملی برای کیفیت جستجو در منطقه 65٪ است..."

("آنچه از TREC آموخته ایم و یاد نگرفته ایم"، دونا هارمن)

هر مدلی که باشد، موتور جستجو به "تنظیم" نیاز دارد - ارزیابی کیفیت جستجو و تنظیم پارامترها. ارزیابی کیفیت یک ایده اساسی برای تئوری جستجو است. زیرا دقیقاً به لطف ارزیابی کیفیت است که می توان در مورد کاربرد یا عدم کاربرد یک مدل خاص صحبت کرد و حتی جنبه های نظری آنها را مورد بحث قرار داد.

به طور خاص، یکی از محدودیت های طبیعی کیفیت جستجو، مشاهده ای است که در متن نوشته شده است: نظرات دو "ارزیابی کننده" (متخصصانی که در مورد ارتباط حکم می کنند) به طور متوسط تا حد زیادی با یکدیگر منطبق نیستند! این حاکی از حد بالایی طبیعی برای کیفیت جستجو است، زیرا کیفیت بر اساس نتایج مقایسه با نظر ارزیاب اندازهگیری میشود.

«... وقتی شخصی از گوگل شوکه شدمبه من گفت که آنها اصلاً از هیچ چیز توسعه یافته در TREC استفاده نمی کنند، زیرا همه الگوریتمهایی که در مسیر «درخواستهای خودسرانه» تیز شدهاند، توسط هرزنامهها درهم شکسته میشوند...»

زمان بازگشت به موضوعی است که این مقاله با آن آغاز شد: اخیراً چه چیزی در موتورهای جستجو تغییر کرده است؟

اول از همه، مشخص شد که جستجو در اینترنت به هیچ وجه نمی تواند به درستی انجام شود، زیرا تنها بر اساس تجزیه و تحلیل (حتی هر چقدر هم عمیق، معنایی و غیره) از متن سند باشد. بالاخره برون متنی (خاموش-صفحه) عواملی که نقشی کمتر و گاهی حتی بیشتر از متن خود صفحه ندارند. موقعیت در سایت، ترافیک، منبع منبع، دفعات به روز رسانی، نقل قول از صفحه و نویسندگان آن - همه این عوامل را نمی توان تخفیف داد.

موتورهای جستجو با تبدیل شدن به منبع اصلی اطلاعات مرجع برای نوع بشر، به منبع اصلی ترافیک سایت های اینترنتی تبدیل شده اند. در نتیجه، بلافاصله توسط نویسندگان بیوجدانی که میخواستند به هر قیمتی در صفحات اول نتایج جستجو ظاهر شوند، مورد حمله قرار گرفتند. نسل مصنوعی صفحات ورودی سرشار از کلمات پرطرفدار، تکنیکهای پنهانسازی، «متن کور» و بسیاری از تکنیکهای دیگر که برای فریب دادن موتورهای جستجو طراحی شدهاند، فوراً اینترنت را غرق کردند.

علاوه بر مشکل رتبه بندی صحیح، سازندگان موتورهای جستجوی اینترنتی باید مشکل به روز رسانی و همگام سازی یک مجموعه عظیم را با فرمت های ناهمگون، روش های تحویل، زبان ها، رمزگذاری ها و بسیاری از متون بی معنی و تکراری حل کنند. لازم است پایگاه داده را در حالت حداکثر تازگی نگه دارید (در واقع، ایجاد توهم تازگی کافی است - اما این موضوع بحث دیگری است)، شاید با در نظر گرفتن ترجیحات فردی و جمعی کاربران. بسیاری از این مشکلات قبلاً در علم بازیابی اطلاعات سنتی مورد توجه قرار نگرفته بودند.

به عنوان مثال، اجازه دهید به چند مورد از این قبیل مشکلات و راه های عملی برای حل آنها در موتورهای جستجوی اینترنتی نگاه کنیم.

کیفیت رتبه بندی

همه معیارهای برون متنی به یک اندازه مفید نیستند. این محبوبیت پیوند و مشتقات آن بود که عامل تعیین کننده ای بود که در سال های 1999-2000 تغییر کرد. دنیای موتورهای جستجو و وفاداری کاربرانی که به آنها بازگشته اند. از آنجایی که با کمک آن بود که موتورهای جستجو آموختند که به طور شایسته و مستقل (بدون پشتیبانی از نتایج ویرایش شده به صورت دستی) پاسخهای پرسشهای فرکانس کوتاه را که بخش قابل توجهی از جریان جستجو را تشکیل میدهند، رتبهبندی کنند.

ساده ترین ایده برای ردیابی جهانی (یعنی ایستا) محبوبیت پیوند، شمارش تعداد پیوندهایی است که به صفحات اشاره می کنند. این تقریباً همان چیزی است که در علم کتابداری سنتی شاخص استنادی نامیده می شود. این معیار از قبل از سال 1998 در موتورهای جستجو مورد استفاده قرار گرفت. با این حال، به راحتی در معرض تقلب است، علاوه بر این، وزن خود منابع را در نظر نمی گیرد.

توسعه طبیعی این ایده را می توان الگوریتم ارائه شده توسط برین و پیج در سال 1998 در نظر گرفت رتبه صفحه- یک الگوریتم تکراری شبیه به آنچه در مسئله تعیین برنده در مسابقات شطرنج سوئیس استفاده می شود. همراه با جستجوی لغوی پیوندهایی که به یک صفحه اشاره میکنند (یک ایده قدیمی و بسیار سازنده که در دهه 80 در موتورهای جستجوی فرامتن استفاده میشد)، این معیار باعث افزایش چشمگیر کیفیت جستجو شد.

کمی زودتر از رتبه صفحه، یک الگوریتم حسابداری محبوبیت محلی (یعنی پویا، مبتنی بر پرس و جو) پیشنهاد شد - بازدیدها(کلینبرگ) که عمدتاً به دلیل هزینه محاسباتی آن در عمل استفاده نمی شود. تقریباً به همان دلیلی که روشهای محلی (یعنی پویا) روی کلمات کار میکنند.

هر دو الگوریتم، فرمول آنها و شرایط همگرایی به تفصیل شرح داده شده اند، از جمله در ادبیات روسی زبان. من فقط متذکر می شوم که محاسبه محبوبیت ثابت به خودی خود یک کار ارزشمند نیست و برای اهداف کمکی متعددی استفاده می شود: تعیین ترتیب خزیدن اسناد، رتبه بندی جستجوها بر اساس متن پیوندها و غیره. فرمول های محاسبه محبوبیت دائماً در حال بهبود است و آنها عوامل اضافی را در نظر می گیرند - نزدیکی موضوعی اسناد (به عنوان مثال، یک موتور جستجوی محبوب). www.teoma.com)، ساختار آنها و غیره، که اجازه می دهد تا تأثیر خویشاوندی را کاهش دهد. یک موضوع جداگانه جالب پیاده سازی کارآمد ساختارهای داده مناسب (Bharat) است.

کیفیت شاخص

اگرچه اندازه پایگاه داده اینترنتی در نگاه اول عامل مهمی به نظر نمی رسد، اما اینطور نیست. جای تعجب نیست که افزایش ترافیک خودروهایی مانند گوگلو سریع، به خوبی با رشد پایه های آنها همبستگی دارد. دلیل اصلی: پرس و جوهای "نادر"، یعنی مواردی که کمتر از 100 سند برای آنها وجود دارد، حدود 30٪ از کل حجم جستجوها را تشکیل می دهد - بخش بسیار مهمی است. این واقعیت، اندازه پایگاه داده را به یکی از مهم ترین پارامترهای سیستم تبدیل می کند.

با این حال، علاوه بر مشکلات فنی با دیسک ها و سرورها، رشد پایگاه داده نیز توسط موارد منطقی محدود می شود: نیاز به پاسخ کافی به زباله ها، تکرارها و غیره. نمیتوانم الگوریتم مبتکرانهای را که در موتورهای جستجوی مدرن برای حذف «اسناد بسیار مشابه» استفاده میشود، توصیف نکنم.

منشا کپی اسناد در اینترنت ممکن است متفاوت باشد. ممکن است یک سند در همان سرور به دلایل فنی متفاوت باشد: در قالببندیها و قالبهای مختلف ارائه شود، حاوی متغیرهای درج - تبلیغات یا تاریخ فعلی باشد.

دسته گسترده ای از اسناد در وب به طور فعال کپی و ویرایش می شوند - فیدهای خبرگزاری، اسناد و اسناد قانونی، لیست قیمت فروشگاه ها، پاسخ به سوالات متداول و غیره. انواع رایج تغییرات: تصحیح، سازماندهی مجدد، بازبینی، چکیده، افشای موضوع و غیره. در نهایت، انتشارات ممکن است به گونهای کپی شوند که حق نسخهبرداری را نقض کرده و به طور مخرب اصلاح شوند تا کشف آنها دشوار شود.

علاوه بر این، نمایه سازی صفحات تولید شده از پایگاه های داده توسط موتورهای جستجو باعث ایجاد دسته رایج دیگری از اسناد می شود که از نظر ظاهری تفاوت چندانی ندارند: پرسشنامه ها، انجمن ها، صفحات محصول در فروشگاه های الکترونیکی.

بدیهی است که در مورد تکرارهای کامل مشکل خاصی وجود ندارد، کافی است جمع چکی متن را در فهرست ذخیره کنید و همه متون دیگر را با همان چک جمع نادیده بگیرید. با این حال، این روش برای شناسایی اسناد حتی کمی تغییر یافته کار نمی کند.

برای حل این مشکل، Udi Manber (نویسنده برنامه معروف جستجوی مستقیم تقریبی agrep) در سال 1994 این ایده را ارائه کرد و آندری برودر در سال 1997 نامی را مطرح کرد و الگوریتم "زونا" را به ذهن آورد (از کلمه زونا- "کاشی، ترازو"). در اینجا یک توصیف تقریبی از آن است.

برای هر متن ده کلمه ای، یک چک سام (شینگل) محاسبه می شود. دهها کلمه روی هم میافتند، روی هم میافتند، به طوری که حتی یک کلمه هم گم نمیشود. و سپس، از کل مجموعه چک ها (بدیهی است که تعداد آنها به تعداد کلمات در سند منهای 9 وجود دارد)، فقط آنهایی که بر مثلاً 25 تقسیم می شوند انتخاب می شوند، زیرا مقادیر چک شده توزیع می شوند به طور مساوی، معیار انتخاب به هیچ وجه به ویژگی های متن گره خورده است. واضح است که تکرار حتی یک جمله ده کلمه ای نشانه قابل توجهی از تکرار است، اما اگر تعداد آنها زیاد باشد، مثلاً بیش از نصف باشد، آنگاه با اطمینان خاصی (به راحتی می توان احتمال را تخمین زد) می توان بگو: یک نسخه پیدا شد! به هر حال، یک شینگل منطبق در نمونه با تقریباً 25 کلمه ده کلمه ای منطبق در متن کامل مطابقت دارد!

بدیهی است که از این طریق می توانید درصد همپوشانی متن را تعیین کنید، تمام منابع آن را شناسایی کنید و غیره. این الگوریتم زیبا، رویای دیرینه دانشیاران را محقق کرده است: از این پس می توان این سوال دردناک را که "دانشجو این درس را از چه کسی کپی کرده است" حل شده تلقی کرد! ارزیابی نسبت سرقت ادبی در هر مقاله آسان است.

برای اینکه خواننده این تصور را نداشته باشد که بازیابی اطلاعات یک علم انحصاری غربی است، من یک الگوریتم جایگزین برای شناسایی موارد تقریبا تکراری که در اینجا در Yandex (ایلینسکی) اختراع و پیاده سازی شده است، ذکر می کنم. از این واقعیت استفاده می کند که بیشتر موتورهای جستجو از قبل یک فهرست به شکل یک فایل معکوس (یا شاخص معکوس) دارند و این واقعیت را می توان به راحتی در روند یافتن موارد تکراری استفاده کرد.

قیمت یک درصد

از نظر معماری، سیستم های جستجوی مدرن، سیستم های پیچیده چند کامپیوتری هستند. با شروع از یک نقطه خاص، با رشد سیستم، بار اصلی به هیچ وجه بر روی ربات نیست، بلکه بر روی جستجو می افتد. به هر حال، ده ها و صدها درخواست در عرض یک ثانیه می رسد.

برای مقابله با این مشکل، ایندکس به بخشهایی تقسیم میشود و در دهها، صدها یا حتی هزاران رایانه پخش میشود. خود کامپیوترها از سال 1997 (موتور جستجو اینکتومی) ماشین های معمولی 32 بیتی هستند ( لینوکس, سولاریس, FreeBSD, برنده شوید32 ) با محدودیت های مربوط به قیمت و عملکرد. تنها استثنا قاعده کلی است AltaVista، که از همان ابتدا از رایانه های نسبتاً "بزرگ" 64 بیتی استفاده می کرد آلفا.

موتورهای جستجوی اینترنتی (و به طور کلی همه موتورهای جستجوی بزرگ) می توانند با استفاده از تکنیک های echeloning و pruning سرعت کار خود را افزایش دهند.

اولین تکنیک این است که شاخص را به بخش های آشکارا مرتبط تر و کمتر مرتبط تقسیم کنیم. جستجو ابتدا در قسمت اول انجام می شود و سپس در صورت یافتن چیزی یا کم، موتور جستجو به قسمت دوم فهرست دسترسی پیدا می کند. هرس کردن (از انگلیسی. هرس کردن- "برش، کاهش") متوقف کردن پویا پردازش یک درخواست پس از جمع آوری مقدار کافی از اطلاعات مربوطه است. هرس ایستا نیز وجود دارد، زمانی که بر اساس فرضیات خاص، شاخص به هزینه اسنادی کاهش می یابد که مطمئناً هرگز پیدا نمی شوند.

یک مشکل جداگانه سازماندهی عملکرد بدون وقفه سیستم های چند کامپیوتری، به روز رسانی یکپارچه شاخص، و مقاومت در برابر خرابی ها و تاخیر در پاسخ های اجزای جداگانه است. پروتکل های ویژه ای برای ارتباط بین سرورهای جستجو و سرورهایی که پاسخ ها را جمع آوری کرده و صفحه نتایج جستجو را تشکیل می دهند، در حال توسعه هستند.

توجه داشته باشید که یک درصد عملکرد (مثلاً یک عبارت ضعیف نوشته شده در یک حلقه) برای ده هزار سیستم کامپیوتری حدود صد کامپیوتر هزینه دارد. بنابراین، می توانید تصور کنید که چگونه کد مسئول جستجو و رتبه بندی نتایج پاک می شود، چگونه استفاده از همه منابع ممکن بهینه می شود: هر بایت حافظه، هر دسترسی به دیسک.

فکر کردن در مورد معماری کل مجموعه از همان ابتدا بسیار مهم است، زیرا هر گونه تغییر - به عنوان مثال، اضافه کردن یک عامل غیر معمول در رتبه بندی یا یک منبع داده پیچیده - به یک روش بسیار دردناک و پیچیده تبدیل می شود. بدیهی است سیستم هایی که دیرتر شروع به کار می کنند در این شرایط مزیت دارند. اما اینرسی کاربر بسیار زیاد است: برای مثال، دو تا چهار سال طول می کشد تا یک مخاطب چند میلیون دلاری تثبیت شده، هرچند به آرامی، به یک سیستم جستجوی غیرمعمول سوق پیدا کند، حتی اگر مزایای غیرقابل انکاری داشته باشد. در شرایط رقابت شدید، گاهی اوقات این امر امکان پذیر نیست.

خوشه بندی نحوی وب

آندری ز. برودر، استیون سی گلاسمن، مارک اس. ماناس

WWW6، 1997

تقریب یک ماتریس توسط ماتریس دیگری با رتبه پایین تر

اکارت، جی. روان سنجی یانگ، 1936

شرح و تجزیه و تحلیل عملکرد روش های فایل امضا

فالوتسوس، اس. کریستودولاکیس

ACM TOIS، 1987

بازیابی اطلاعات با استفاده از مدل تجزیه ارزش منفرد ساختار معنایی پنهان

G.W. Furnas، S. Deerwester، S.T. دومایس، T.K. لاندوئر، آر. ای. هارشمن، لس آنجلس. استریتر و ک.ای. لوچباوم

ACM SIGIR، 1988

نمونه هایی از PAT به کار رفته در فرهنگ لغت انگلیسی آکسفورد

گونت جی.

دانشگاه واترلو، 1987

رویکرد اصطلاحنامه به بازیابی اطلاعات

تی جویس و آر.ام. نیدم

اسناد آمریکایی، 1958

روشی کارآمد برای تشخیص تکراری اسناد وب با استفاده از نمایه معکوس

S. Ilyinsky، M. Kuzmin، A. Melkov، I. Segalovich

WWW2002، 2002

آرایه های پسوندی: روشی جدید برای جستجوهای رشته ای آنلاین

یو. منبر، جی. مایرز

اولین سمپوزیوم ACM-SIAM در مورد الگوریتم های گسسته، 1990

یافتن فایل های مشابه در یک سیستم فایل بزرگ

یو. منبر

کنفرانس USENIX، 1994

در مورد ارتباط، نمایه سازی احتمالی و بازیابی اطلاعات

M.E. مارون و جی.ال. کوهنز

مجله ACM، 1960

وزن مربوط به عبارات جستجو

S.E. رابرتسون و کی اسپارک جونز

جیسیس، 1976

الگوریتم ها در C++

رابرت سج ویک

ادیسون-وسلی، 1992

تفسیر آماری ویژگی اصطلاح و کاربرد آن در بازیابی

کی اسپارک جونز

مجله اسناد، 1972

بازیابی اطلاعات زبان طبیعی

تومک استرشالکوفسکی (ویرایشگر)

ناشران آکادمیک Kluwer، 1999

سمفونی یا فرهنگ لغت فهرست کتاب مقدس عهد عتیق و جدید

گردآوری شده توسط M.A. بوندارف، M.S. کوسیان، اس.یو. کوسیان

انتشارات پدرسالار مسکو، 1995

واژه نامه

ارزیاب (ارزیاب، متخصص) - یک متخصص در زمینه موضوعی که در مورد ارتباط سندی که توسط یک موتور جستجو پیدا شده است نتیجه گیری می کند.

مدل بولی (بولی، بولی، بولی، باینری) یک مدل جستجو بر اساس عملیات تقاطع، اتحاد و تفریق مجموعه ها است.

مدل برداری- یک مدل بازیابی اطلاعات که اسناد و پرس و جوها را به عنوان بردار در فضای کلمه و ارتباط را به عنوان فاصله بین آنها در نظر می گیرد.

مدل احتمالی- یک مدل بازیابی اطلاعات که ارتباط را به عنوان احتمال تطبیق یک سند معین با یک پرس و جو بر اساس احتمال تطبیق کلمات یک سند داده شده با یک پاسخ ایده آل در نظر می گیرد.

معیارهای برون متنی (خاموش-صفحه، خارج از صفحه) - معیارهایی برای رتبه بندی اسناد در موتورهای جستجو، با در نظر گرفتن عواملی که در متن خود سند موجود نیست و به هیچ وجه از آنجا استخراج نشده است.

صفحات ورودی (درگاه ها، راهروها) - صفحات ایجاد شده برای افزایش مصنوعی رتبه در موتورهای جستجو (هرزنامه جستجو). هنگامی که آنها فرود می آیند، کاربر به صفحه فرود هدایت می شود.

ابهام زدایی (برچسب زدن, بخشازسخنرانیابهام زدایی, برچسب زدن) - انتخاب یکی از چندین همنام با استفاده از متن. در انگلیسی اغلب به تخصیص خودکار دسته دستوری "بخشی از گفتار" می رسد.

موارد تکراری (تکراری) - اسناد مختلف با محتوای یکسان، از دیدگاه کاربر؛ تکراری تقریبی (نزدیکتکراری، تقریباً تکراری)، بر خلاف موارد تکراری دقیق، دارای تفاوت های جزئی هستند.

توهم طراوت- تأثیر تازگی ظاهری که توسط موتورهای جستجوی اینترنتی با خزیدن منظم تر اسنادی که اغلب توسط کاربران پیدا می شوند به دست می آید.

فایل وارونه (وارونهفایل, inverse file, inverted index, inverted list) یک فهرست موتور جستجو است که کلمات مجموعه ای از اسناد را فهرست می کند و برای هر کلمه تمام مکان هایی را که در آن رخ داده است فهرست می کند.

شاخص (شاخص، فهرست) - نمایه سازی را ببینید.

نمایه استناد (نقل قولشاخص) - تعداد ارجاعات (استنادها) یک مقاله علمی، در علم کتابشناسی سنتی در یک دوره زمانی مثلاً در طول یک سال محاسبه می شود.

نمایه سازی (نمایه سازی, نمایه سازی) فرآیند کامپایل یا اختصاص یک اشاره گر (شاخص) است - یک ساختار داده خدمات لازم برای جستجوی بعدی.

جستجوی اطلاعات (اطلاعاتبازیابیIR) - جستجوی اطلاعات بدون ساختار، که واحد ارائه آن سندی از قالب های دلخواه است. موضوع جستجو نیاز اطلاعاتی کاربر است که به طور غیررسمی در عبارت جستجو بیان شده است. هم معیار جستجو و هم نتایج آن قطعی نیستند. این ویژگیها بازیابی اطلاعات را از «بازیابی دادهها» متمایز میکند که بر روی مجموعهای از محمولات رسمی تعریف شده عمل میکند، با اطلاعات ساختاریافته سروکار دارد و نتیجه آن همیشه قطعی است. تئوری بازیابی اطلاعات همه اجزای فرآیند جستجو، یعنی پیش پردازش متن (نمایه گذاری)، پردازش و اجرای پرس و جو، رتبه بندی، رابط کاربری و بازخورد را مطالعه می کند.

پنهان کاری (پوشش) - تکنیک جستجوی هرزنامه، که شامل شناسایی توسط نویسندگان اسناد ربات (عامل نمایه سازی) موتور جستجو و تولید محتوای ویژه برای آن است که اساساً با محتوای داده شده به کاربر متفاوت است.

کنتراست اصطلاحی- قدرت متمایز را ببینید.

نمایه سازی معنایی نهفته- یک الگوریتم جستجوی حق اختراع برای معنا، یکسان با تحلیل عاملی. بر اساس تجزیه ارزش منفرد ماتریس ارتباطات بین کلمات و اسناد.

Lemmatization (ریشه یابی، عادی سازی) - آوردن شکل یک کلمه به یک فرم فرهنگ لغت، یعنی یک لم.

تقلب موتورهای جستجو- هرزنامه موتور جستجو را ببینید.

خویشاوندی- نوعی اسپم موتورهای جستجو، نصب پیوندهای متقابل توسط نویسندگان سند تنها به منظور بالا بردن رتبه آنها در نتایج جستجو.

وقوع معکوس در اسناد (وارونهسندفرکانس, ارتش اسرائیل، فرکانس معکوس در اسناد، فرکانس معکوس سند) نشانگر ارزش جستجوی یک کلمه (قدرت متمایز آن) است. معکوس به این دلیل گفته می شود که هنگام محاسبه این شاخص، مخرج کسری معمولاً شامل تعداد اسناد حاوی این کلمه است.

بازخورد- پاسخ کاربر به نتیجه جستجو، قضاوت آنها در مورد ارتباط اسناد یافت شده، ثبت شده توسط سیستم جستجو و استفاده، به عنوان مثال، برای اصلاح تکراری پرس و جو. باید از شبه بازخورد، یک تکنیک اصلاح پرس و جو که در آن چند سند اولیه یافت شده به طور خودکار مرتبط تلقی می شوند، متمایز شود.

همنام- چندمعنایی را ببینید.

پیچ و تاب- بخشی از یک کلمه مشترک به مجموعه ای از اشکال اشتقاقی و عطفی (بیشتر) آن.

جستجو بر اساس معنی- یک الگوریتم بازیابی اطلاعات که قادر به یافتن اسنادی است که حاوی کلمات پرس و جو نیستند.

اسناد مشابه را جستجو کنید (مشابهسندجستجو کنید) - یک کار بازیابی اطلاعات که در آن خود سند به عنوان یک پرس و جو عمل می کند و لازم است اسنادی را پیدا کنید که بیشتر شبیه به مورد داده شده باشند.

موتور جستجو (جستجو کنیدموتور, S.E.، سیستم بازیابی اطلاعات، IRS، موتور جستجو، موتور جستجو، "موتور جستجو"، "موتور جستجو") - برنامه ای است که برای جستجوی اطلاعات، معمولا اسناد متنی طراحی شده است.

جستجوی نسخه (پرس و جو، درخواست) - معمولاً یک خط متن.

چند معنایی (چند معنایی، چند معنایی) - وجود چندین معنی برای یک کلمه.

کامل بودن (به یاد بیاور,پوشش) نسبت مطالب مرتبط موجود در پاسخ موتور جستجو نسبت به تمام مطالب مرتبط در مجموعه است.

تقریبا تکراری (نزدیک-تکراری، موارد تکراری تقریبی) - به موارد تکراری مراجعه کنید.

هرس کردن (هرس کردن) - قطع کردن اسناد آشکارا نامربوط در حین جستجو به منظور سرعت بخشیدن به اجرای پرس و جو.

جستجوی مستقیم- جستجوی مستقیم از طریق متن اسناد، بدون پردازش اولیه (بدون نمایه سازی).

شبه بازخورد- بازخورد را ببینید.

قدرت متمایز کلمات (مدتخاص بودن, مدتتبعیض آمیزقدرت، کنتراست ، قدرت متمایز) - درجه عرض یا باریکی یک کلمه. عبارات جستجویی که خیلی گسترده هستند، اطلاعات زیادی را به ارمغان می آورند و بسیاری از آنها بی فایده هستند. اصطلاحات بسیار محدود به یافتن اسناد بسیار کمی کمک می کند، هرچند اسناد دقیق تر.

بیان منظم (منظمبیان, الگو، "الگو"، کمتر "استنسیل"، "ماسک") - راهی برای ضبط یک دستورالعمل جستجو که به شما امکان می دهد خواسته های کلمه جستجو شده، املای احتمالی، خطاها و غیره را تعیین کنید. در معنای وسیع، زبانی است که به شما امکان می دهد پرس و جوهایی با پیچیدگی نامحدود را مشخص کنید.

ارتباط (ارتباط، ارتباط) - مطابقت سند با درخواست.

امضا (امضا، امضا) - مجموعه ای از مقادیر هش کلمات یک بلوک خاص از متن. هنگام جستجو توسط روش امضاهمه امضاهای همه بلوکهای مجموعه به صورت متوالی در جستجوی مطابقت با مقادیر هش کلمات جستجو جستجو میشوند.

عطف (عطف) - تشکیل شکلی با معنای دستوری خاص، معمولاً در یک زمینه دستوری معین اجباری، متعلق به مجموعه ثابتی از اشکال (پارادایم) مشخصه کلمات یک نوع معین. برخلاف واژهسازی، هرگز منجر به تغییر نوع نمیشود و معنایی قابل پیشبینی را به وجود میآورد. عطف نام ها را کج می گویند (انحراف) ، و افعال - صرف (صرف) .

واژه سازی (اشتقاق) - تشکیل کلمه یا ریشه از کلمه یا ریشه دیگر.

متمایز- قدرت متمایز را ببینید.

هرزنامه موتور جستجو (هرزنامه، هرزنامه، تقلب موتورهای جستجو) - تلاش برای تأثیرگذاری بر نتیجه جستجوی اطلاعات از سوی نویسندگان اسناد.

محبوبیت ایستا- سانتی متر رتبه صفحه.

ساقه- فرآیند شناسایی ریشه یک کلمه.

کلمات امن (توقف-کلمات) - آن دسته از حروف ربط، حروف اضافه و سایر کلمات متداول که یک موتور جستجوی معین از فرآیند نمایه سازی و جستجو حذف کرده است تا عملکرد و/یا دقت جستجو را بهبود بخشد.

درختان پسوند، آرایه های پسوندی (پسونددرختان, پسوندآرایه ها, PAT-آرایه ها) شاخصی است که بر اساس نمایش تمام پسوندهای مهم یک متن در یک ساختار داده معروف به "بور" (تلاش کن) . پسونداین شاخص به هر «رشته فرعی» اشاره دارد که از نقطه ای در متن شروع می شود (متن به عنوان یک خط پیوسته در نظر گرفته می شود) و تا انتهای آن ادامه می یابد. در برنامه های واقعی، طول پسوندها محدود است و فقط موقعیت های مهم نمایه می شوند - به عنوان مثال، ابتدای کلمات. این شاخص به شما امکان می دهد پرس و جوهای پیچیده تری را نسبت به فهرستی که بر روی فایل های معکوس ساخته شده است انجام دهید.

توکن سازی (نشانه گذاری, واژگانیتجزیه و تحلیل، تجزیه و تحلیل نموداری، تحلیل واژگانی) - برجسته کردن کلمات، اعداد و نشانه های دیگر در متن، از جمله، به عنوان مثال، یافتن مرزهای جمله.

دقت (دقت) - سهم مطالب مرتبط در پاسخ موتور جستجو.

مقدار هش (هش-ارزش) - معنی توابع هش (هش-عملکرد) ، که داده های با طول دلخواه (معمولاً یک رشته) را به تعدادی از یک مرتبه ثابت تبدیل می کند.

فراوانی (کلمات) در اسناد (سندفرکانس، وقوع در اسناد، فراوانی سند) - تعداد اسناد موجود در مجموعه حاوی یک کلمه معین.

فرکانس مدت (مدتفرکانس، تی اف) - فراوانی استفاده از یک کلمه در یک سند.

زونا (زونا) - مقدار هش یک دنباله پیوسته از کلمات متنی با طول ثابت.

رتبه صفحه- الگوریتمی برای محاسبه محبوبیت ایستا (جهانی) یک صفحه در اینترنت، به نام یکی از نویسندگان، لارنس پیج. مربوط به احتمال ضربه زدن کاربر به صفحه در مدل پیاده روی تصادفی است.

TF* ارتش اسرائیل- اندازه گیری عددی مطابقت بین یک کلمه و یک سند در یک مدل برداری. بیشتر از نسبتاً بیشترکلمه در سند ظاهر شد و نسبتا کمتر- در مجموعه